Projekte

XR4DRAMA ist ein EU‑H2020‑Projekt, das die Situationserfassung und Entscheidungsfindung in......

XR4DRAMA

Beschreibung:

XR4DRAMA ist ein EU‑H2020‑Projekt, das die Situationserfassung und Entscheidungsfindung in Krisensituationen und bei Medienproduktionen durch den Einsatz von Extended Reality (XR) und ergänzenden Technologien revolutionieren möchte. Der Proof‑of‑Concept konzentriert sich zunächst auf Katastrophen‑ und Medienmanagement und strebt danach, die gewonnenen Erkenntnisse und Systeme anschließend auf weitere Einsatzfelder zu übertragen.

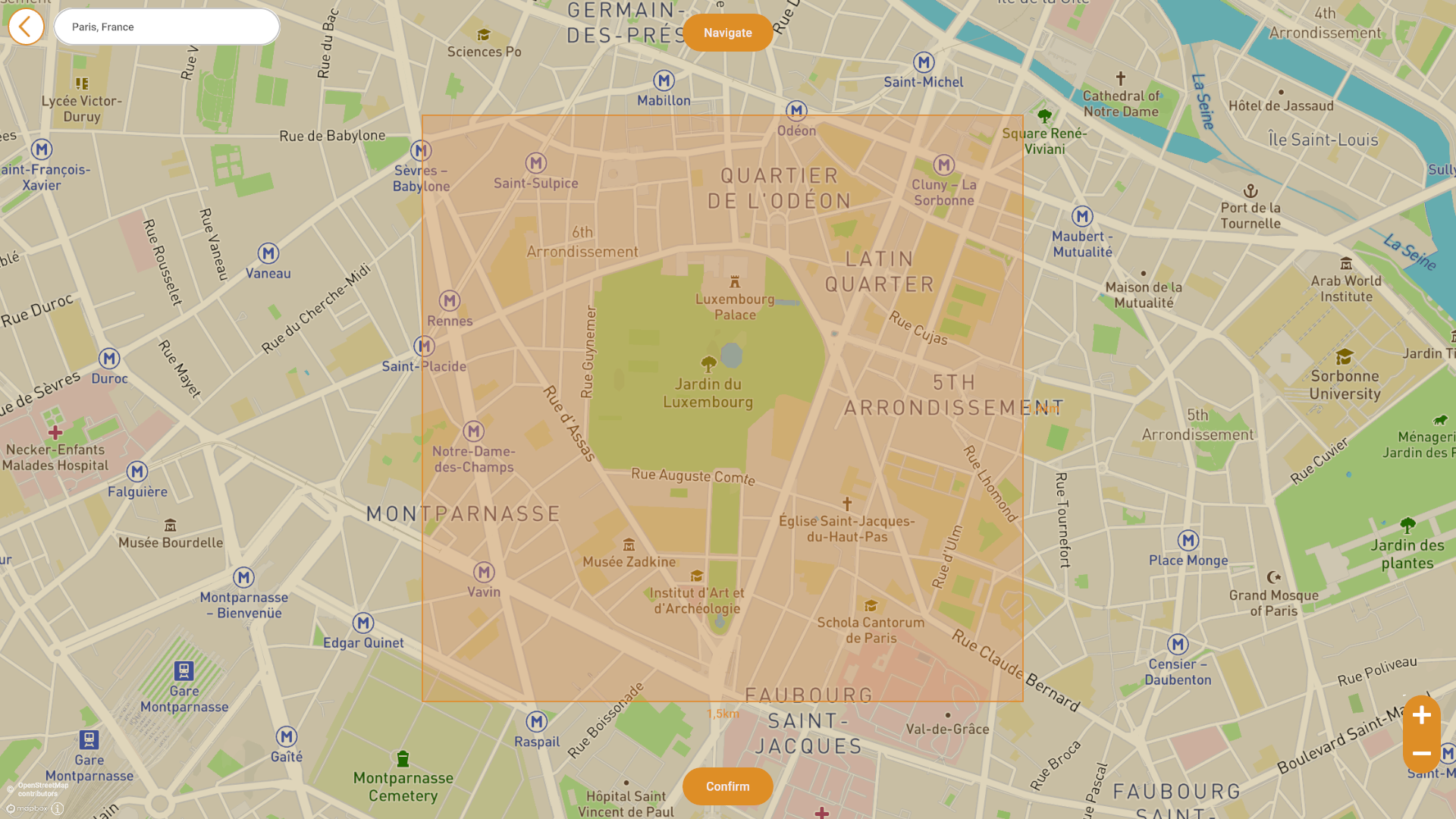

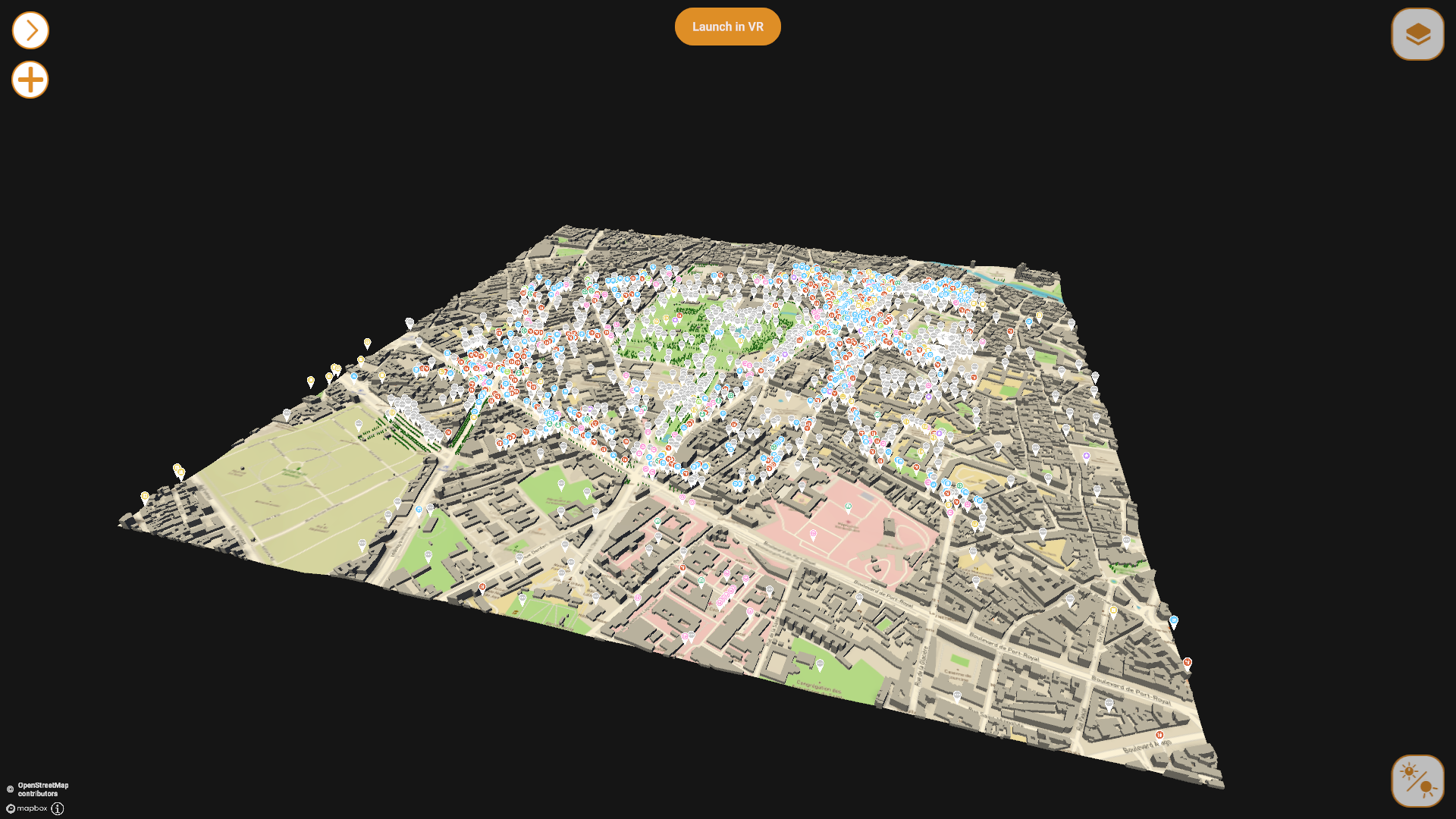

XR4DRAMA verfolgt einen datengetriebenen Ansatz: Katastrophenmanager, Ersthelfer, Journalisten und Medienproduzenten erhalten Zugriff auf umfangreiche Daten – von geografischen Karten über soziografische Informationen, kulturellen Kontext bis hin zu Sensordaten wie Temperatur, Feuchtigkeit und insbesondere Messwerte zu Wasserständen sowie Überflutungsprognosen. Diese Daten werden in einem zentralen Control‑Center‑System georeferenziert dargestellt, von Orten von Interesse für die Medienproduktion bis zu kritischen Messdaten für den Katastrophenfall. Die Anwendung lässt sich sowohl auf Desktop‑ und Mobilgeräten als auch in Virtual Reality (VR) nutzen. In VR kann die Umgebung in einer mittels Photogrammetrie erstellten 3‑D‑Welt erlebbar gemacht werden, sodass Beteiligte ein „wie vor Ort“‑Erlebnis erhalten und die Lage in realitätsnaher Perspektive erfassen können.

Ein zentraler Aspekt von XR4DRAMA ist die „verteilte Situationsbewusstheit“. Die georeferenzierte Darstellung von Standorten und Ereignissen muss kontinuierlich aktualisiert werden. Das Control‑Center bietet daher Schnittstellen zwischen entfernten Managern und vor Ort tätigen Personen, sodass Informationen in Echtzeit ausgetauscht und die Situation in der VR‑Umgebung laufend aktualisiert wird. So entsteht ein gemeinsames, dynamisch veränderliches Verständnis der Umgebung, das es ermöglicht, Entscheidungen in Echtzeit sicher und effizient zu treffen.

Kurz gesagt sorgt XR4DRAMA dafür, dass alle relevanten digitalen Informationen zentral gesammelt, in einer immersiven XR‑Umgebung dargestellt und kontinuierlich aktualisiert werden – von Katastrophen‑Messdaten bis hin zu Medienproduktionsanwendungen – und schafft damit eine verteilte, datengetriebene Situationsbewusstheit, die die Planung, Entscheidungsfindung und Durchführung von Maßnahmen in kritischen Szenarien erheblich verbessert.

Aufgaben:

Mein Team trug die komplette Verantwortung für die Konzeption, Architektur und Implementierung des Control‑Centers, das die Herzstück‑Komponente von XR4DRAMA darstellt. Die Software visualisiert geo‑referenzierte Daten in Echtzeit und zeigt dabei nicht nur die Lage von Orten von Interesse für die Medienproduktion, sondern auch die genauen Positionen von Einsatzpersonen. Jedes Teammitglied wird auf der Karte mit einem Stress‑Level‑Indikator dargestellt, sodass Operatoren sofort erkennen können, wer in Gefahr ist oder zusätzliche Unterstützung benötigt.

Zur Erweiterung der Situationsbewusstheit integrierten wir Social‑Media‑Inhalte mithilfe von KI‑Modellen. Beiträge werden automatisch durchsucht, relevante Informationen werden klassifiziert und auf der Karte angezeigt. Benutzer können nach verschiedenen Typen filtern, wie z.B. etwa Gefahrenmeldungen. Zusätzlich erhalten Operateure durch KI‑analysierte Bilder Einblicke in Personen in Gefahr oder andere kritische Szenarien. Das System priorisiert diese Informationen nach ihrer Dringlichkeit, sodass Operatoren stets die wichtigsten Daten im Blick haben.

Der Operator des Control‑Centers hat über die Software die Möglichkeit, Einsatzpersonen Aufträge zu erteilen, ihnen zusätzliche Informationen zukommen zu lassen und gleichzeitig deren Arbeitsbelastung zu überwachen. Dadurch kann sichergestellt werden, dass Einsatzkräfte nicht übermäßig belastet werden.

Ein weiteres Highlight der Architektur ist die Möglichkeit, mehrere Personen gleichzeitig dezentral zu bedienen. Durch Voice‑Chat in VR können sich Einsatzkräfte virtuell treffen, sich austauschen und gemeinsam die Situation analysieren. Für die Medienproduktion habe ich einen VR‑Drohne eintwickelt: Die Drohne lässt sich neben dem regulären Flugmodus in der VR‑Umgebung starten, wodurch Teams einen realistischen Eindruck von Kamerawinkeln und Blickfeld erhalten. Zusätzlich wurde eine Tag‑/Nacht‑Lichtsimmulation implementiert, die es ermöglicht, Faktoren wie Schattenwurf, Lichtverhältnisse und deren Einfluss auf Aufnahmen bereits in der Planungsphase zu berücksichtigen.

Skills & Technologies:

Screenshots:

Videos:

IMOCO4.E ist ein EU-finanziertes Forschungsprojekt, das eine edge‑to‑cloud‑basierte......

IMOCO4.E

Beschreibung:

IMOCO4.E ist ein EU-finanziertes Forschungsprojekt, das eine edge‑to‑cloud‑basierte Bewegungssteuerungsintelligenz für Human‑in‑the‑Loop Systeme entwickelt. Ziel ist die Bereitstellung einer Referenzplattform, die KI‑ und Digital‑Twin‑Toolchains sowie modulare Bausteine für robuste Fertigungsanwendungen kombiniert. Die Plattform soll durch Energieeffizienz, einfache Konfiguration, Nachvollziehbarkeit und Cybersicherheit überzeugen und wird in einer Reihe von Anwendungsfeldern – von der Halbleiter- und Verpackungsindustrie bis hin zu industriellen Robotern und Gesundheitssystemen – getestet, um die Vorteile in allen Teilen der Produktions‑ und AnwendungsKette zu demonstrieren. Im Kern setzt IMOCO4.E neue Sensortechnologien, modellbasierte Ansätze und das Industrial‑Internet‑of‑Things ein, um mechatronische Systeme intelligenter, anpassungsfähiger, zuverlässiger und leistungsfähiger zu machen, während gleichzeitig ihre Leistung an die physischen Grenzen angeglichen wird. Das Projekt bewertet die Anforderungen an die zukünftige Smart‑Manufacturing‑Infrastruktur in Europa und kooperiert mit dem Industry‑4.E‑Cluster sowie weiteren Lighthouse‑Projekten, um Best‑Practice‑Methoden für das europäische Forschungs‑ und Innovationsökosystem zu definieren. An zwei Pilotprojekte waren wir an praktische Umsetzung beteiligt:

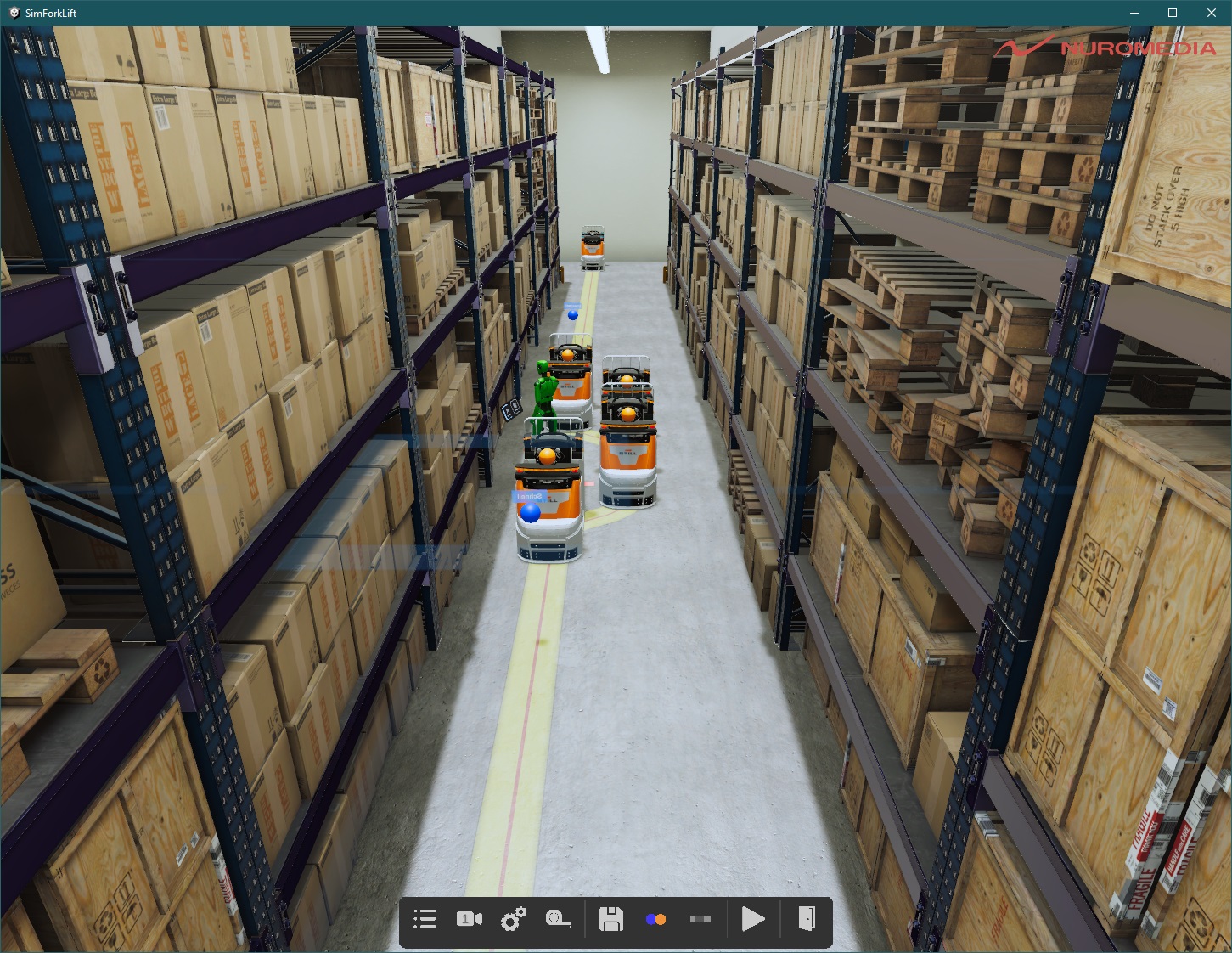

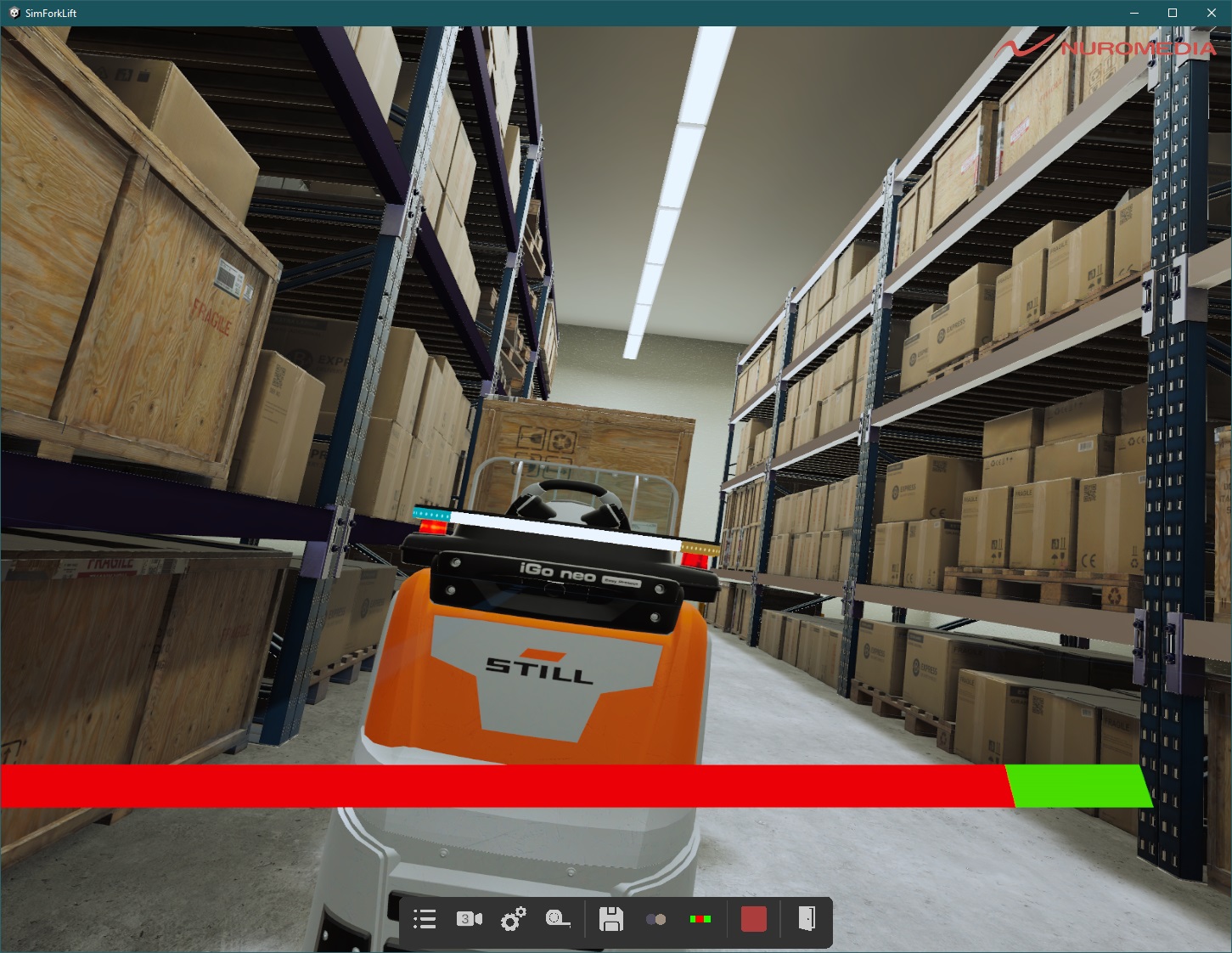

1) STILLs „iGo neo“ – ein autonom fahrendes Lagerfahrzeug – nutzt digitale Zwillinge und KI, um durch hochsensible Laserscanner, Kameras und Radar die Umgebung in Echtzeit zu erfassen, Hindernisse zu erkennen und selbstständig Pfade zu planen

2) die ADAT3‑XF‑Die‑Attach‑Plattform von Nexperia ITEC, unterstützt von einem digitalen Zwilling, steigert die Präzision, Produktionsrate (bis zu 72 000 Produkte/Std.) und Prozessportabilität über mehrere Fertigungslinien hinweg. Durch diese Pilotstudien demonstriert IMOCO4.E, wie intelligente Bewegungssteuerung und Digital‑Twin‑Technologien die Effizienz, Zuverlässigkeit und Skalierbarkeit moderner Fertigungssysteme nachhaltig verbessern können.

Aufgaben:

Pilot 1 – iGo neo

Ich entwickelte zunächst einen VR‑Digitalen Zwilling des STILL‑iGo neo, der über einen PlayStation‑4‑Controller, ein Gaming‑Lenkrad und oder eine an das Fahrzeug angebrachte Eathernet bedient werden konnte. Dieser Ansatz wurde zu einer Testumgebung ausgebaut, in der Nutzer Bremspunkte und Ausweichpfade festlegen und in einer sicheren Umgebung simulieren konnten. Die dabei gesammelten Daten dienen einer KI‑Trainingsreihe, die darauf abzielt, regulatorisch zulässige, aber für Menschen zu unangenehme Maßnahmen (z. B. abruptes Bremsen) zu optimieren. Zusätzlich erstellte ich eine zweite Anwendung, die das gesamte Lagerhaus (inklusive eines Ausstattungseditors) abbildet und synthetische Micro‑Doppler‑Radar‑Daten für das KI‑Training generiert. Diese Anwendung wurde mit einem ROS 2‑Interface ausgestattet, sodass die Simulation multi‑userfähig ist und der iGo neo über MATLAB oder Gazebo gesteuert werden kann. Ziel war es, die trainierten KI‑Modelle in einem sicheren Testumfeld insbesondere bei der Maschinen‑Mensch‑Interaktion zu validieren. Parallel unterstützte ich die Entwicklung der Wegfindungsalgorithmen für das Planungs‑Tool, das die Aufgabenverteilung und den Einsatz der autonomen Gabelstapler plant.

Pilot 2 – ADAT3‑XF Digital Twin

Im zweiten Pilotprojekt führte ich die Anforderungsanalyse durch und arbeitete eng mit dem Entwickler zusammen, um die Softwarearchitektur zu entwerfen. Dabei lag der Schwerpunkt auf der Aufteilung von Datenfluss, Simulationsmodellen und Echtzeit‑Schnittstellen. Ich half bei der Umsetzung, insbesondere bei Problemen mit physikalischen Berechnungen und der Echtzeit‑Performance, die bei der Integration des Digital Twins in die bestehende Simmulationspipeline kritische Engpässe verursachten. Durch gezielte Optimierungen und die Implementierung von effizienteren Algorithmen konnten die Simulationsergebnisse verbessert und die Reaktionszeiten der Steuerungssoftware reduziert werden.

Skills & Technologies:

Screenshots:

Videos:

Das HECOF-Projekt hat das Ziel, systemischen Wandel herbeizuführen, indem sie Innovationen in der......

HECOF

Beschreibung:

Das HECOF-Projekt hat das Ziel, systemischen Wandel herbeizuführen, indem sie Innovationen in der Lehre an Hochschulen fördert und nationale Bildungsreformen unterstützt. Dies soll durch die Entwicklung und Erprobung einer innovativen, personalisierten und adaptiven Lehrmethode erreicht werden, die digitale Daten aus den Lernaktivitäten der Studierenden in immersiven Umgebungen nutzt und rechnergestützte Analysetechniken aus der Datenwissenschaft und der Künstlichen Intelligenz einsetzt.

Ein zentrales Element des Projekts ist die Entwicklung eines benutzerfreundlichen Authoring Tools, das Lehrenden die Möglichkeit gibt, ohne tiefgreifende Programmierkenntnisse eigene VR-Lerninhalte zu erstellen. Dieses Tool soll eine modulare Struktur besitzen und unterschiedliche didaktische Szenarien unterstützen – von explorativen Lerninhalten bis hin zu interaktiven Simulationen. Durch intuitive Benutzeroberflächen, Vorlagen und anpassbare Elemente wird sichergestellt, dass Lehrende flexibel auf die Bedürfnisse ihrer Studierenden eingehen können. Zudem ermöglicht die Integration von Analysetools eine kontinuierliche Optimierung der Inhalte auf Basis von Nutzungs- und Lerndaten.

Aufgaben:

Im Rahmen der Umsetzung des Authoring Tools für VR-Lerninhalte war ich maßgeblich an der Konzeption und technischen Realisierung beteiligt. Zu meinen Aufgaben zählten die Durchführung einer fundierten Requirementsanalyse in enger Zusammenarbeit mit Lehrkräften und Studierenden der National Technical University of Athens (NTUA) und der Politecnico di Milano (POLIMI). Ziel war es, spezifische didaktische Anforderungen aus den Fachbereichen Chemieingenieurwesen (NTUA: Extraktion von Stoffen aus Olivenbaumblättern) sowie Biotechnologie (POLIMI: Zusammenbau und Simulation eines Bioreaktors) in funktionale Softwareanforderungen zu überführen.

Darauf aufbauend übernahm ich die Beratung hinsichtlich geeigneter Entwicklungsstrategien sowie die Konzeption der Softwarearchitektur des Tools. In der Rolle als technischer Projektverantwortlicher leitete ich zudem ein interdisziplinäres Team aus Entwickler:innen und 3D-Artists, koordinierte Arbeitsabläufe und stellte die technische und gestalterische Umsetzung der Inhalte sicher.

Die technische Realisierung erfolgte unter Einsatz modernster Technologien wie Unity, Virtual Reality, Künstlicher Intelligenz (inkl. Large Language Models und adaptiver AI), Text-to-Speech (TTS), RESTful APIs, JSON, Echtzeit-Rendering, Datenkompression und kryptografischer Verfahren. Durch die Kombination dieser Technologien wurde ein leistungsfähiges und gleichzeitig flexibel erweiterbares System geschaffen, das immersive und interaktive Lerninhalte auf hohem didaktischen und technischen Niveau ermöglicht.

Skills & Technologies:

XR4ED ist eine digitale Plattform, die sich auf zwei zentrale Angebote konzentriert: zunächst......

XR4ED

Beschreibung:

XR4ED ist eine digitale Plattform, die sich auf zwei zentrale Angebote konzentriert: zunächst einen Online‑Shop, in dem Lehrkräfte, Schulen und Unternehmen fertige XR‑Lernmodule, interaktive 3D‑Modelle, Lehrvideos und Praxisaufgaben sowie sämtliche Werkzeuge und Ressourcen zum Erstellen von XR‑Inhalten erwerben können. Parallel dazu bietet die Plattform ein umfangreiches Authoring‑Tool, mit dem pädagogische Fachkräfte VR‑Lerneinheiten ohne tiefgehende Programmierkenntnisse gestalten, bearbeiten und veröffentlichen können. Das Tool liefert ein Drag‑and‑Drop‑Interface, einen Szenengenerator, interaktive Objekt‑Platzierung und Skript‑Templates, die die komplette Erstellung von VR‑Lernmaterialien ermöglichen und die Umsetzung von Lehrkonzepten in immersive, erlebnisorientierte Lernumgebungen unterstützen.

Über ein Jahr hinweg haben 20 verschiedene Teams aus Bildungseinrichtungen, Forschungsgruppen und Industriepartnern die Plattform intensiv genutzt. Durch kontinuierliches Feedback wurden die Funktionen, das Design und die Benutzerfreundlichkeit des Authoring‑Tools laufend erweitert, angepasst und verbessert. Nach Abschluss dieser Testphase konnten wurden die Ergebnisse durch Tausenden von Schülern und Studierenden verwendet.

Aufgaben:

Ich habe das Authoring‑Tool selbst entworfen von der Gesamtarchitektur über das UX‑Konzept bis hin zum Datenmanagement und weiteren Schlüsselkomponenten. Zusammen mit meinem Team habe ich die eigentliche Umsetzung übernommen und dabei ein breites Spektrum an Systemkomponenten entwickelt, um die unterschiedlichen Zielgruppen und Erfahrungsstufen abzudecken:

- No‑Code Drag‑and‑Drop‑Lösungen für Pädagog*innen, die sofort einsatzbereite VR‑Lernmodule erstellen wollen.

- Node‑Editor für technisch versierte Anwender, der das Einfügen einfacher Logik und Interaktionen ermöglicht, ohne dass Code geschrieben werden muss.

- Compiler‑Modul zur Erstellung und Ausführung von eigenen Skripten, damit Entwickler*innen die volle Flexibilität besitzen, komplexe Lehrkonzepte zu realisieren.

Neben der Entwicklung habe ich gemeinsam mit meinem Team die laufende Betreuung und technischen Support für die Plattform übernommen, um sicherzustellen, dass Anwender bei Fragen und Problemen stets schnell Hilfe erhalten.

Weitere technische Deiteils sind im Betrag zum World Builder zu finden, der das Resultat der Entwicklung darstellt.

Skills & Technologies:

SENSE (Strengthening Cities and Enhancing Neighbourhood Sense of Belonging) baut ein europaweites......

SENSE

Beschreibung:

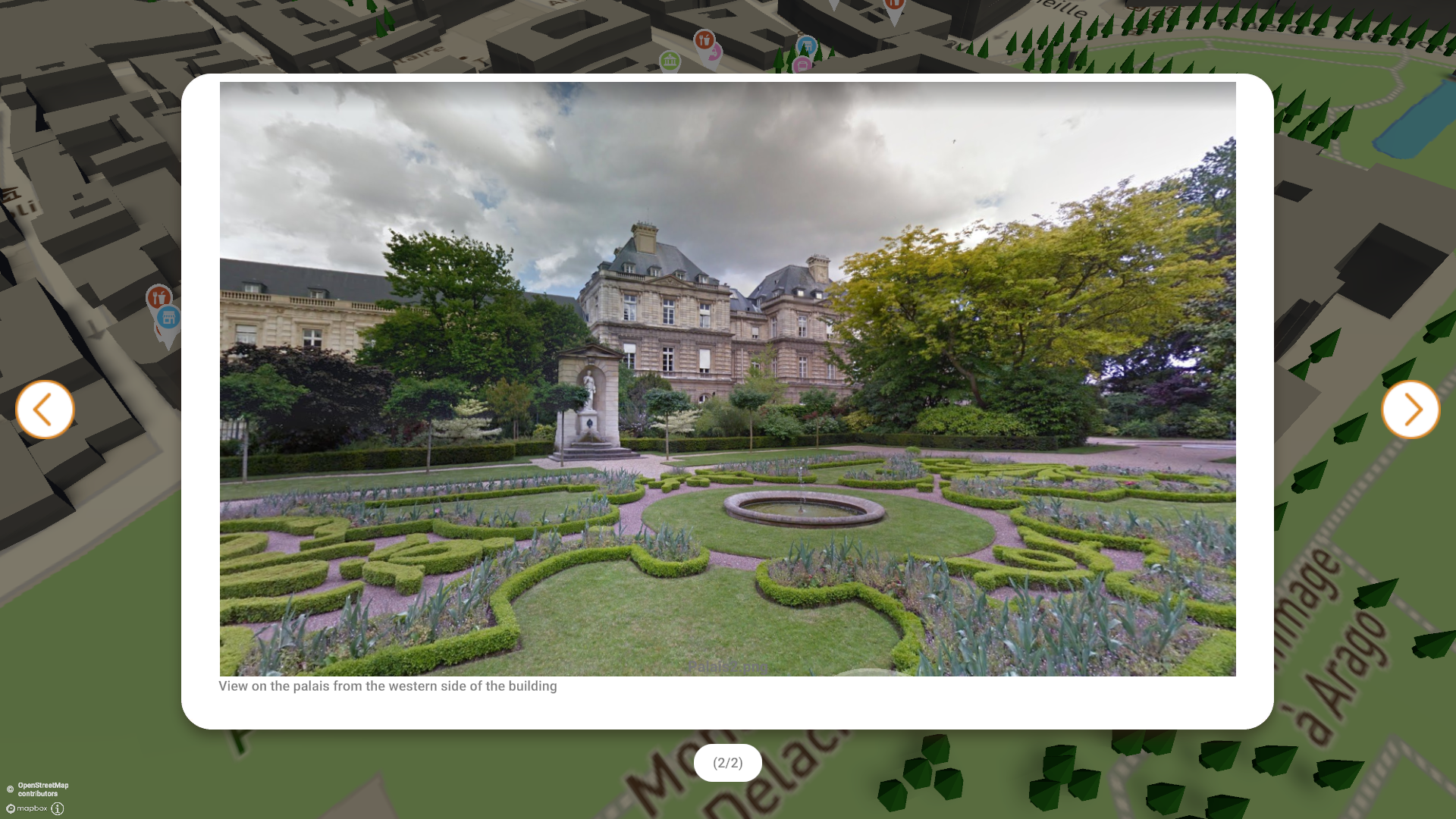

SENSE (Strengthening Cities and Enhancing Neighbourhood Sense of Belonging) baut ein europaweites Netzwerk virtueller Welten auf, die reale Städte im Metaverse nachbilden. Im Einklang mit der EU‑Initiative „Smart Communities“ nutzt das Projekt die EU‑Dateninfrastruktur und arbeitet strikt nach Interoperabilitätsstandards, um praktische Anwendungsfälle für die Plattform CitiVerse zu entwickeln. Ziel ist es, Bürger*innen und Kommunen durch VR/AR‑Erlebnisse in urbanen Räumen zu vernetzen und dabei nicht nur technische, sondern vor allem soziale, architektonische, grüne und kulturelle Dimensionen des Lebens zu stärken. So entsteht ein immersives, verbindendes Umfeld, das das Zugehörigkeitsgefühl in den Städten Europas nachhaltig erhöht.

Aufgaben:

Unser Team war verantwortlich für die Konzeption und Realisierung der VR/AR‑Anwendungen im Rahmen von SENSE. Hierzu haben wir ein spezielles Daten‑Streaming‑Protokoll für den Portal Hopper entwickelt, das die Erstellung von „endlosen“ virtuellen Welten ermöglicht. Durch dieses Protokoll können Landschaften, Gebäude und sämtliche geo‑lokalisierte Daten kontinuierlich gestreamt und in Echtzeit dargestellt werden. Damit schaffen wir eine skalierbare Basis, die es den Nutzern erlaubt, sich nahtlos in riesigen, dynamisch generierten Umgebungen zu bewegen, ohne dass umfangreiche Vorab‑Downloads nötig sind. Dies ist ein entscheidender Schritt, um die Immersion und die Interoperabilität innerhalb des CitiVerse zu maximieren.

Skills & Technologies:

ReliVR ist ein interdisziplinäres Forschungsprojekt, das Virtual‑Reality‑Technologien nutzt,......

ReliVR

Beschreibung:

ReliVR ist ein interdisziplinäres Forschungsprojekt, das Virtual‑Reality‑Technologien nutzt, um die Behandlung schwerer Depressionen zu verbessern und den psychotherapeutischen Bedarf zu ergänzen. Durch die Digitalisierung des Gesundheitswesens eröffnen sich neue Therapiemöglichkeiten, die Behandlungserfolge steigern, Wartezeiten verkürzen und Versorgungslücken insbesondere in strukturschwachen Regionen schließen können.

Das Projekt entwickelt zwei komplementäre Lösungen: Für den Desktop‑Teil wurde ein Patienten‑Web‑Portal konzipiert, das umfassende Nachschlageinformationen, einen Terminkalender sowie ein Tagebuch bietet – so können Betroffene ihre Fortschritte selbstverantwortlich dokumentieren und planen. Im VR‑Segment wurden gezielte Meditationsübungen sowie interaktive Rollenspiele implementiert. Diese Rollenspiele simulieren reale Alltagssituationen: ein Gespräch mit einem Vorgesetzten am Arbeitsplatz sowie ein privates Szenario, in dem der Patient mit einem Freund in einem Café interagiert. Durch das immersive Erleben dieser Situationen sollen soziale Kompetenzen gefördert, Ängste reduziert und Coping‑Strategien trainiert werden.

Parallel zur Entwicklung der Module identifiziert das Team Indikatoren für Depressionen, die den Behandlungserfolg computergestützt verfolgen lassen. Damit können Rückfälle frühzeitig erkannt und Gegenmaßnahmen eingeleitet werden. Abschließend wird das Gesamtsystem im klinischen Setting evaluiert, um die Benutzerfreundlichkeit, Effektivität und den Nutzen für Therapeuten und Patienten zu validieren.

ReliVR liefert damit eine innovative, digitale Ergänzung zu klassischen Therapien – sowohl im stationären als auch im ambulanten oder häuslichen Kontext – und trägt dazu bei, Therapieerfolge schneller zu erreichen und Rückfälle wirksam vorzubeugen.

Aufgaben:

Unser Team hat die gesamte VR-Anwendung für die Meta‑Quest 2 und 3 konzipiert und umgesetzt. Das System ist modular aufgebaut, sodass künftig neue Therapieübungen einfach hinzugefügt werden können. Zusätzlich haben wir ein Aufzeichnungssystem entwickelt, mit dem eine Übung aus der dritten Person wiederholt und analysiert werden kann. Ich habe die zugrundeliegende Architektur sowie das modulare Ladesystem für Inhalte selbst programmiert. Parallel war ich eng in die Partnerbetreuung und -beratung eingebunden und habe die Szenarien für die Therapieübungen mitgestaltet.

Skills & Technologies:

Screenshots:

Der Portal Hopper ist ein spezialisierter Browser für das dreidimensionale Metaverse, das wir......

Portal Hopper

Links:

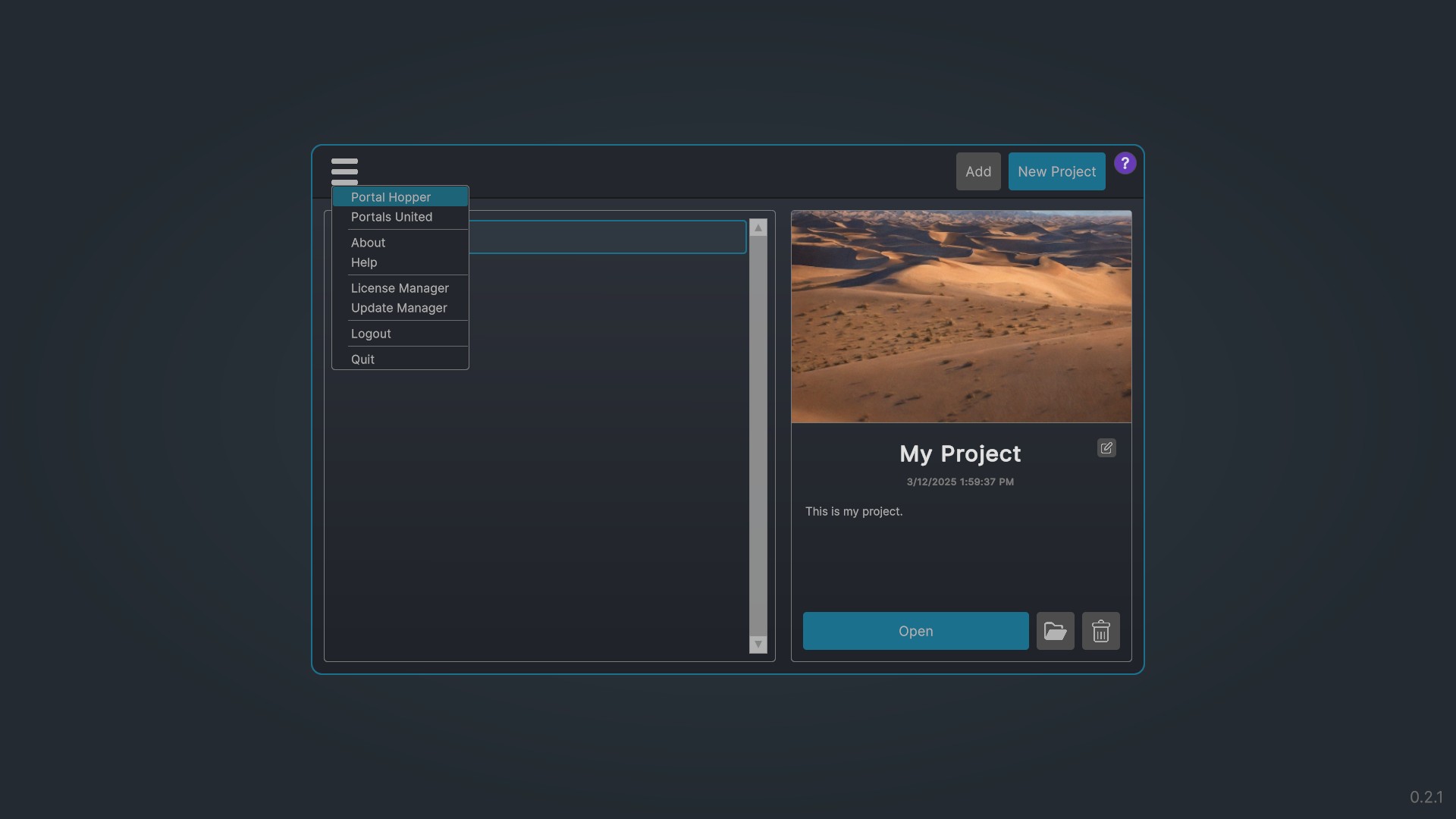

Beschreibung:

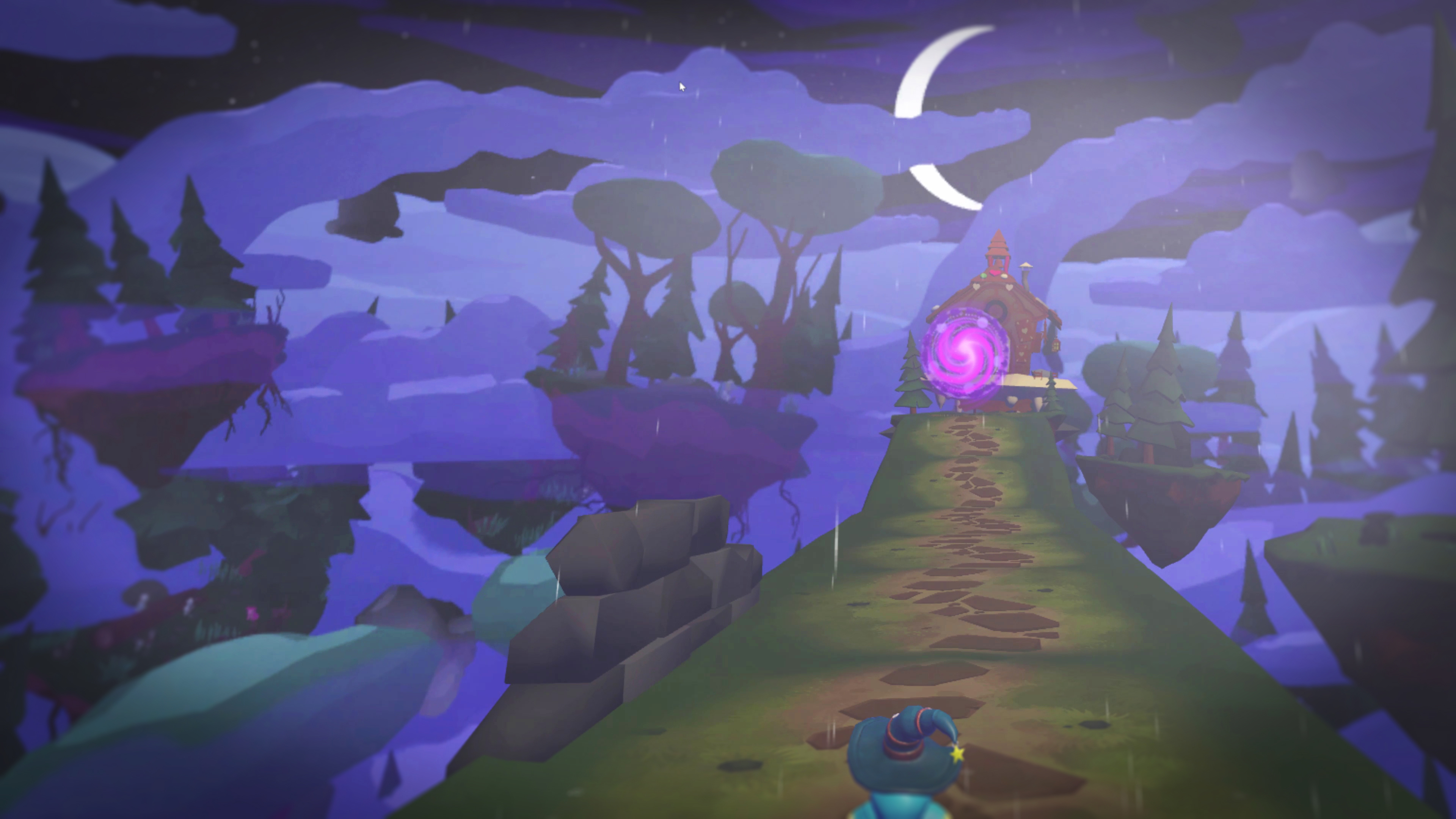

Der Portal Hopper ist ein spezialisierter Browser für das dreidimensionale Metaverse, das wir „VRWeb“ nennen. Er funktioniert nach einem einfachen Protokoll, das sämtliche Welten und Orte in einem Multiverse miteinander verbindet. Ein Hopper muss in der Lage sein, VRML‑Dateien zu interpretieren, die angeben, welcher Hopper benutzt werden muss und wie man zu einer bestimmten Welt gelangt, er kann anschließend entweder die Zielwelt selbst laden oder einen anderen Hopper starten, der diese Welt handhabt. Zusätzlich bietet er die Möglichkeit, Installer für andere hopper‑aware‑Apps auszuführen, sodass auch Spiele mit völlig anderen Physik‑ oder Grafik‑Engines integriert werden können.

Wie ein herkömmlicher Webbrowser ermöglicht der Portal Hopper das „Springen“ zwischen virtuellen Welten, fast wie das Anklicken von Hyperlinks. Man kann beliebige Adressen eingeben, doch die beste Erkundung erfolgt über Entdeckung.Durch Tippen oder Berühren eines Portals (z. B. einer Tür, eines Gangs, einer Statue) gelangt man in eine andere Welt oder eine „Domain“. Portale können unterschiedlich gestaltet sein und müssen nicht zwingend identisch aussehen, sodass Entwickler volle kreative Freiheit besitzen.

Der Hopper behält beim Wechsel zwischen den Orten innerhalb einer Welt Daten wie Spielstände oder Namen, löscht jedoch alle Informationen, wenn man in eine andere Welt springt, um Speicherplatz zu sparen. Dadurch bleibt die Erfahrung konsistent und zugleich ressourcenschonend.

Für eine höchstmöglich Inklusion ist der Portal Hopper in der Lage fließend zwischen einer VR-Ansicht und 1st- bzw. 3rd-Person-View umzustellen. Inhalte müssen dafür nur einmal mit den bereitgestellten Komponenten gebaut werden, so dass die unterschiedlichen Bedienkonzepte natlos beim wechsel ineinandergreifen.

Kurz gesagt: Der Portal Hopper ist der zentrale Browser des VRWeb, der das Metaverse als ein zusammenhängendes Netzwerk von Welten und Orten darstellt – ganz ähnlich wie der World Wide Web im 2D‑Internet, jedoch mit der zusätzlichen Möglichkeit, in einer immersiven 3‑D‑Umgebung zu wandern, zu interagieren und dabei sicher, bezahlt und autorisiert durch eine einheitliche Blockchain‑Infrastruktur zu bleiben.

Aufgaben:

Ich habe gemeinsam mit einem Kollegen den gesamten Portal Hopper, inklusive aller System‑, Komponenten‑ und Modulschnittstellen sowie der Integration von OpenXR – vorwiegend im Pair‑Programming-Ansatz entwickelt. Dabei haben wir die komplette Architektur entworfen, die zugrunde liegende Datenstruktur definiert und ein erstes UX‑Konzept umgesetzt, sodass der Hopper von Grund auf performant, modular und intuitiv funktioniert.

Skills & Technologies:

Das Softwareentwicklungsprojekt „World Builder“ ist ein hochmodernes, WYSIWYG-Authoring‑Tool,......

World Builder

Links:

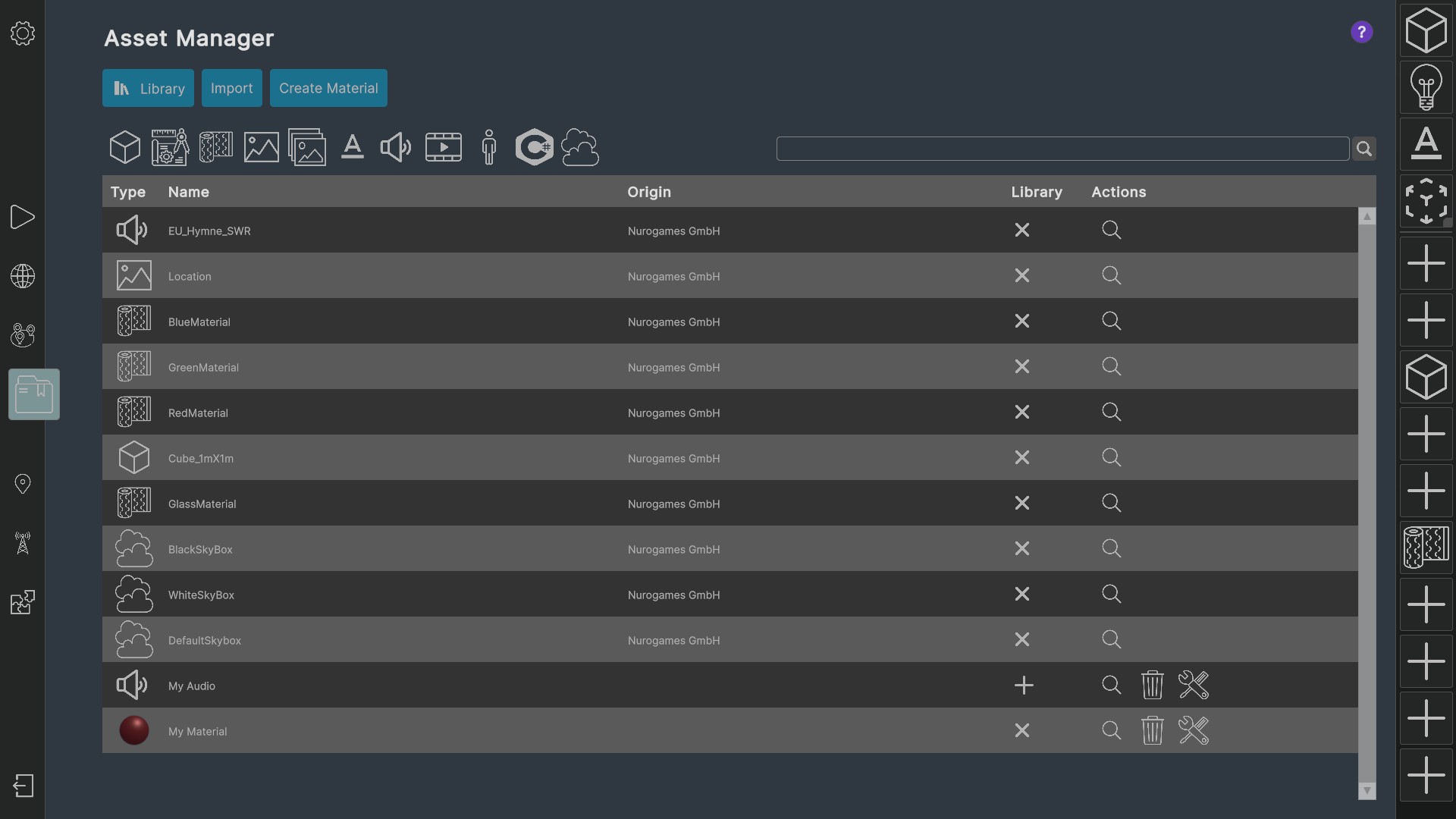

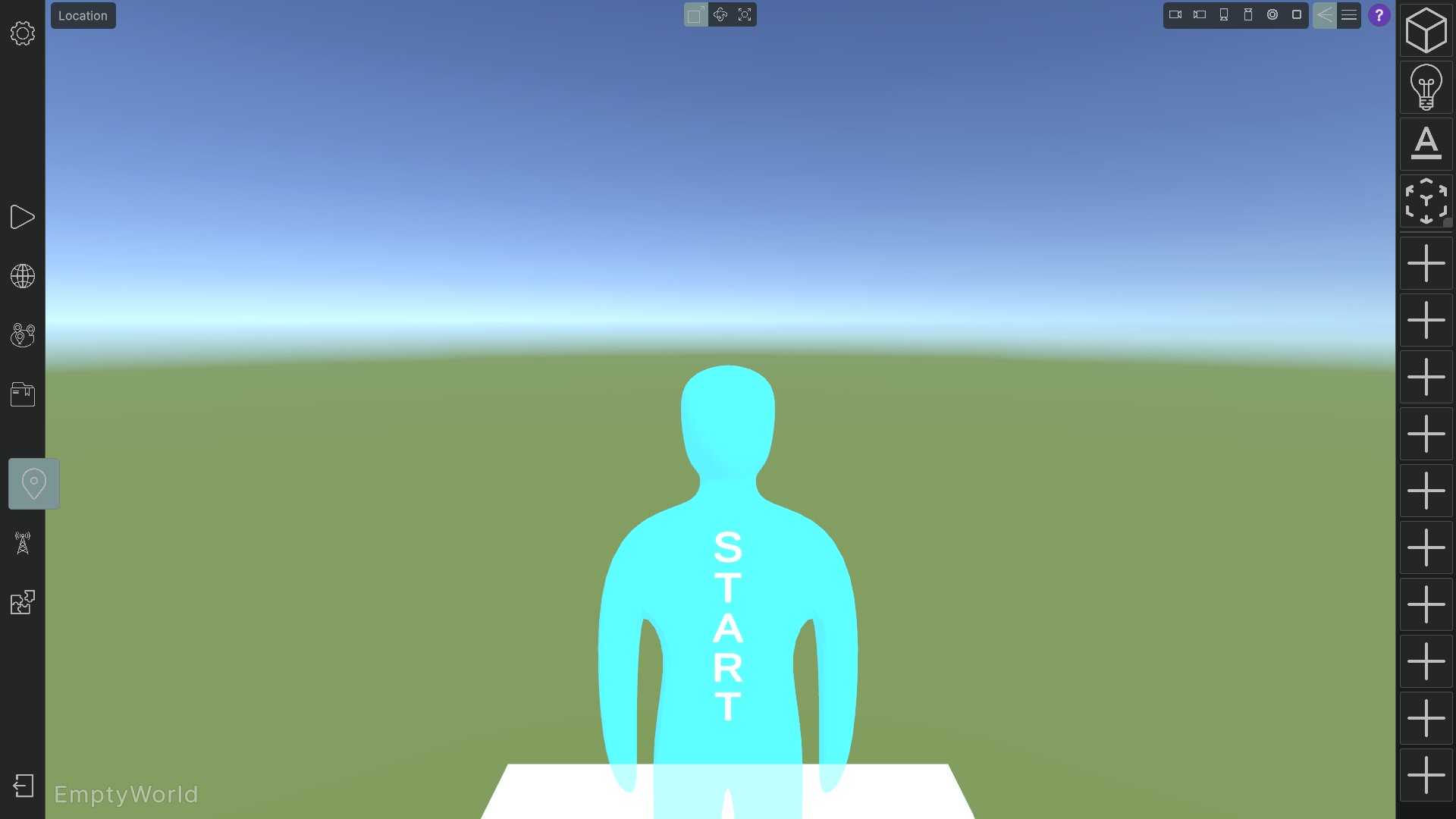

Beschreibung:

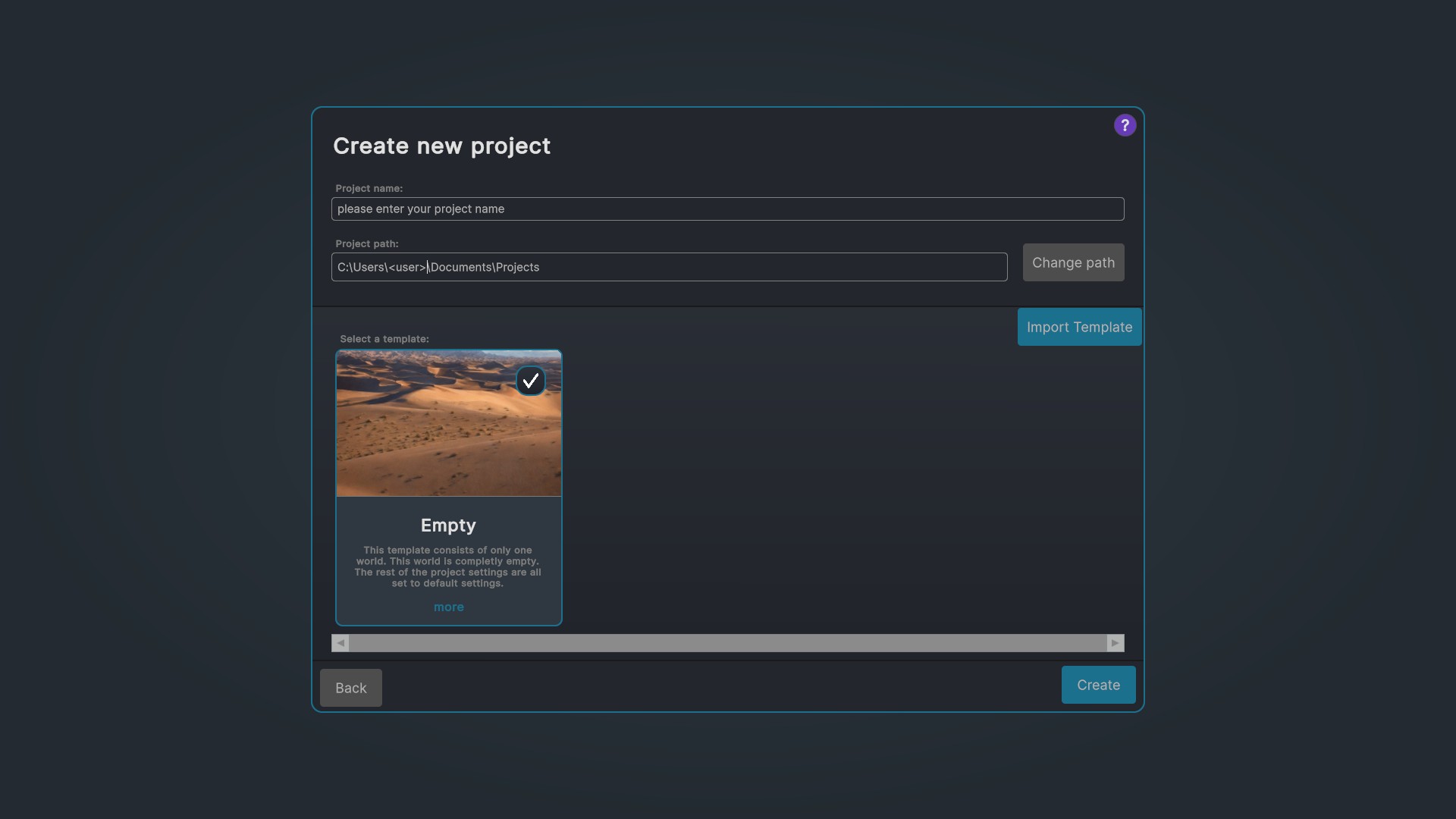

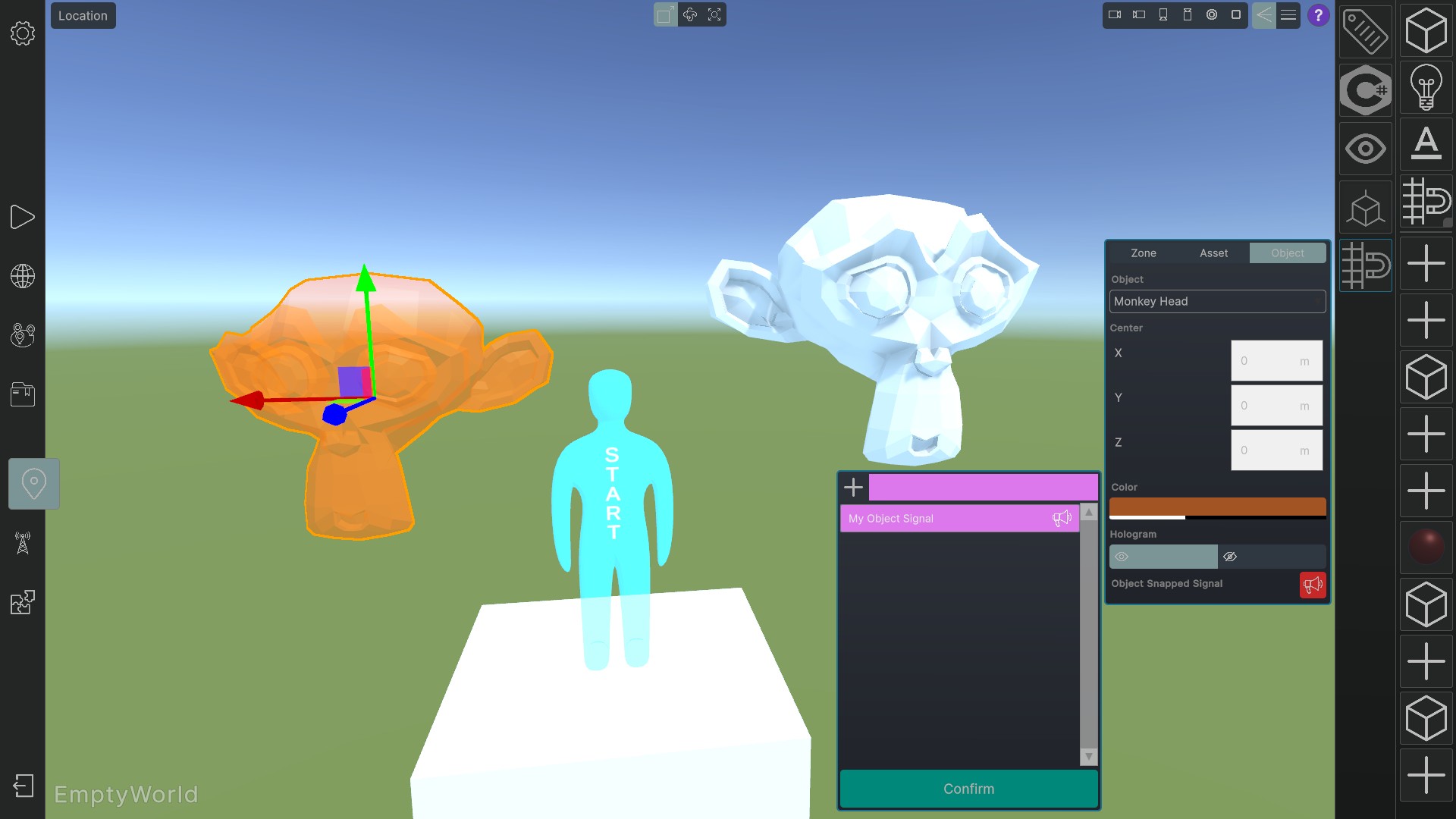

Das Softwareentwicklungsprojekt „World Builder“ ist ein hochmodernes, WYSIWYG-Authoring‑Tool, das speziell für die Erstellung von interaktiven Virtual‑Reality‑Umgebungen konzipiert wurde, welche anschließend in der begleitenden Anwendung „Portal Hopper“ abgespielt werden können. Bereits in einer Vielzahl von Projekten hat der World Builder bewiesen, dass er nicht nur technisch ausgereift, sondern auch äußerst anpassungsfähig ist. Bislang haben mehr als zweihundert Entwickler das Tool eingesetzt und mehrere tausend Endnutzer haben die daraus resultierenden Erlebnisse sowie Lernmodule genutzt.

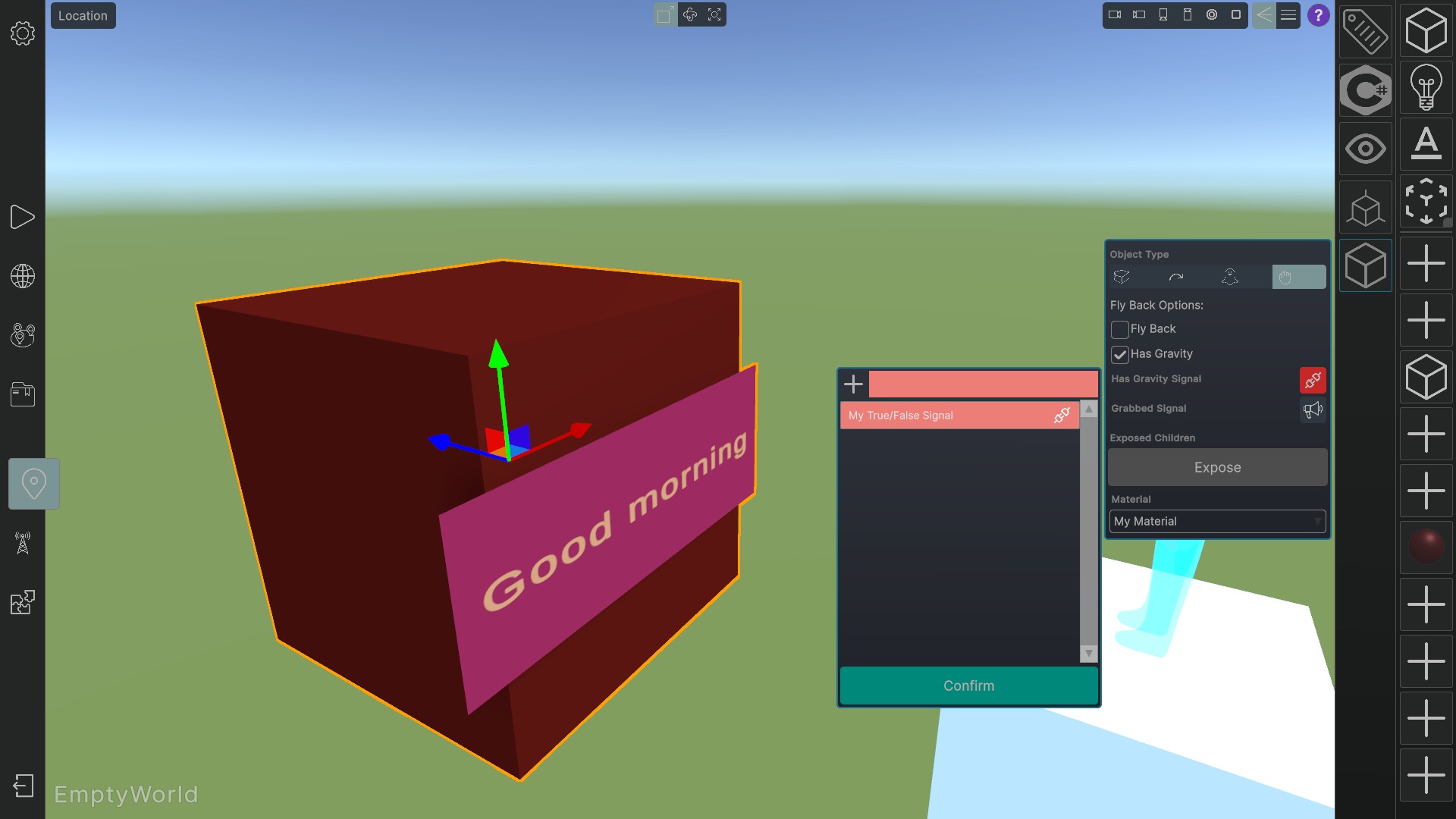

Ein Kernelement des World Builders ist sein White‑Label‑Ansatz. Durch ein flexibles Plugin‑System lässt sich die Anwendung rasch an spezifische Projekte anpassen: Ein Plugin kann das gesamte Erscheinungsbild des Authoring‑Tools branden, die Funktionalität erweitern oder zusätzliche Integrationen einbauen. Auf diese Weise kann die Lösung nahtlos in jede bestehende Produktlinie eingefügt werden, ohne dass grundlegende Strukturen verändert werden müssen. Ergänzend dazu bietet das System vordefinierte Templates für Projekte, Locations und Logik, die den Einstieg erleichtern und ein einheitliches Design gewährleisten.

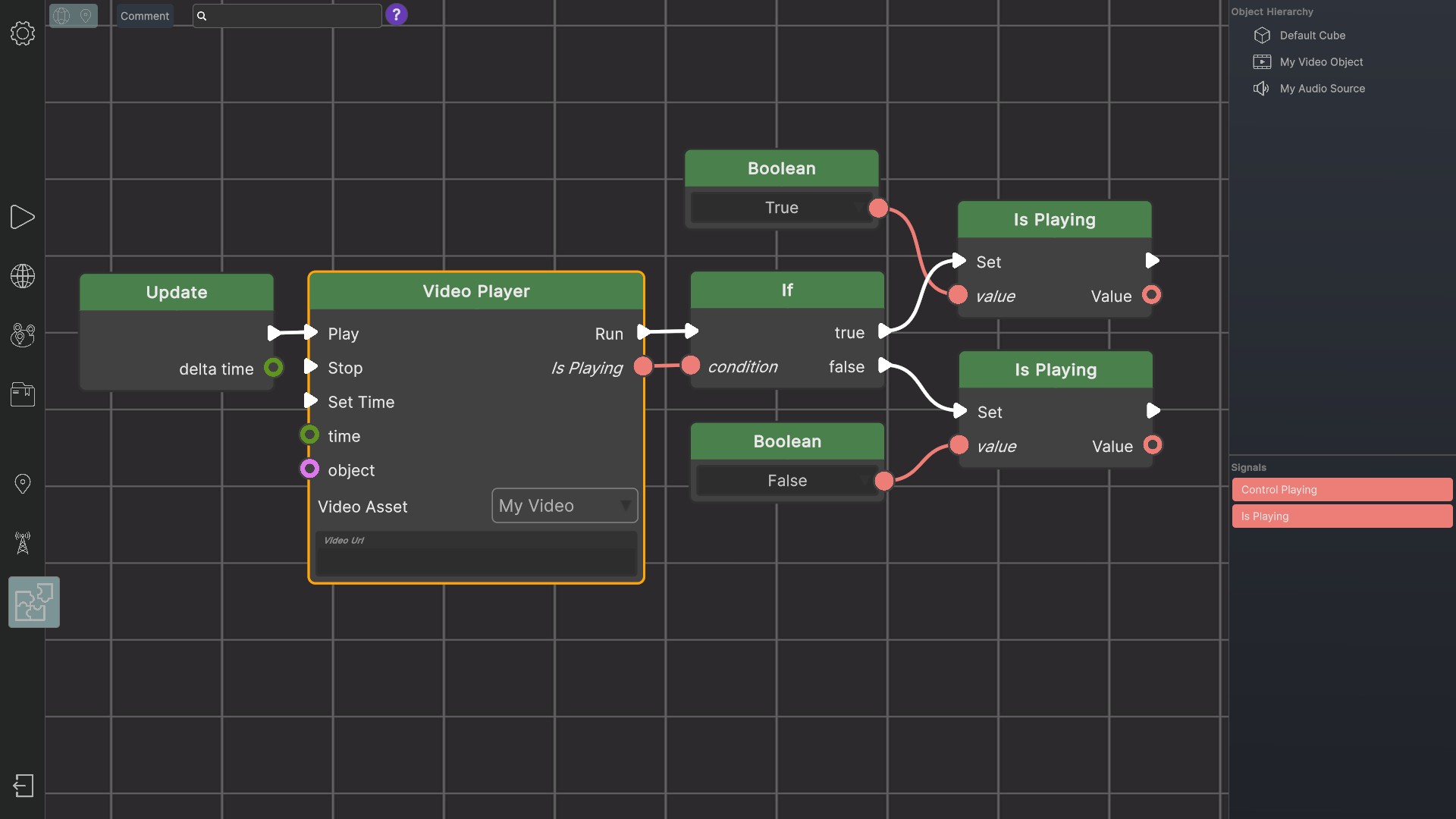

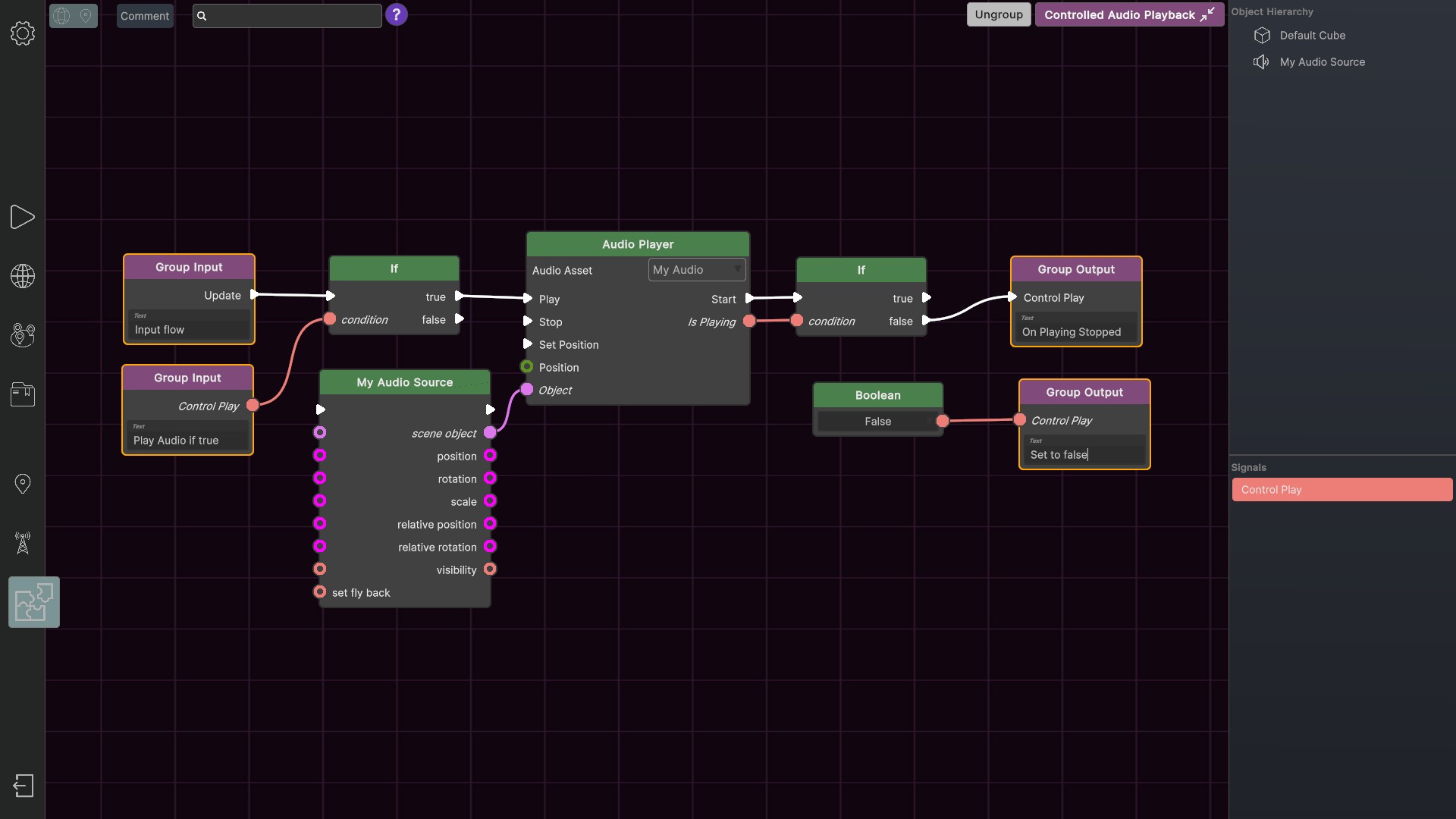

Für die drei Hauptzielgruppen (Anfänger, Advanced/Power‑Users und Entwickler) wurden jeweils spezifische Features implementiert. Anfänger profitieren von Wizards, die sie Schritt für Schritt durch den Prozess führen, sowie von einem direkten Verknüpfungssystem, das die Einrichtung von Verbindungen zwischen Objekten vereinfacht. Power‑Users erhalten einen auf Nodes basierenden Logikeditor, der komplexe Interaktionen visualisiert und bearbeitet werden kann, ohne dass sie sich in Code verlieren. Für Entwickler ist ein integrierter C#‑Compiler verfügbar, der das Erstellen von Skripten ermöglicht und damit die volle Kontrolle über die Logik und Interaktivität bietet. Jede dieser Zielgruppen kann mit gängigen Bild-, 3D‑Model-, Video‑ und Audio‑Formaten arbeiten, wobei gewisse Features auf die Zielgruppe abgestimmt ein- bzw. ausgeschaltet werden können.

Da die herkömmlichen Formate für Szenenbeschreibungen keine nahtlose Einbindung von benutzerdefiniertem Code zulassen, wurde ein eigenes Scene‑Description‑File‑Format entwickelt. Dieses Format erlaubt die Definition aller Elemente einer VR‑Szene – inklusive eigener Logik und ist zugleich leicht erweiterbar.

Ein weiterer Meilenstein ist die Integration generativer KI in den World Builder über Plugins. Durch die Implementierung von Schnittstellen können zusätzliche AI‑Services für sämtliche Asset‑Typen unkompliziert eingebaut werden. Erste Implementierungen von Sprachsteuerung und Tool‑Calling wurden bereits realisiert, was die Grundlage für eine zukünftige sprachbasierte Bedienung bildet. Parallel dazu wird eine KI‑gestützte Dokumentation entwickelt, die den Nutzern bei Fragen zur Verfügung steht und damit den technischen Support entlastet. Diese KI‑Lösung sollen die bereits vorhandenen Asset‑Daten und Projektinformationen nutzen, um kontextrelevante Hilfe anzubieten und Fehlermeldungen proaktiv zu erklären.

Insgesamt bietet der World Builder somit eine vollständig integrierte, modulare Plattform, die von der Idee bis zur Fertigstellung einer VR‑Umgebung reicht. Durch die Kombination aus WYSIWYG-Editor, Plugin‑Architektur, zielgruppenspezifischen Funktionen und modernster KI-Unterstützung setzt das Projekt neue Maßstäbe in der Autorierung von interaktiven VR‑Inhalten. Es ermöglicht Entwicklern, Designern und auch Nicht‑Programmierern, hochwertige virtuelle Welten zu erschaffen, die nahtlos in die „Portal Hopper“-App integriert werden können und gleichzeitig von zukünftigen KI‑Technologien profitieren.

Aufgaben:

In diesem Projekt habe ich die komplette Softwarearchitektur des World Builders von Grund auf übernommen und dabei sämtliche Schichten, von der Anwendungslogik bis zur Persistenzschicht, konsequent geplant und umgesetzt. Parallel dazu habe ich das UI/UX‑Design verantwortet und die gesamte Benutzeroberfläche so gestaltet, dass sie intuitiv bedienbar, visuell ansprechend und gleichzeitig modular erweiterbar ist. In enger Zusammenarbeit mit Kollegen habe ich die Kernsysteme, darunter das Plugin‑Framework, den C#‑Compiler, den Node‑basierten Logikeditor und die generative KI‑Integration, entwickelt. Dadurch habe ich sicher gestellen, dass das Know‑How nicht nur in einer einzigen Person verankert ist. Zusätzlich habe ich den technischen Support strukturiert und ein Help‑Desk‑Konzept eingeführt, das sowohl proaktive als auch reaktive Hilfestellungen umfasst. Meine Verantwortung erstreckte sich weiter auf die Kommerzialisierung des Produkts, bei der ich die Marktstrategie definiert und ausgearbeitet habe. Schließlich war ich maßgeblich an der Ausarbeitung von Projektangeboten beteiligt und habe aktiv an Ausschreibungen für neue Projekte teilgenommen, um den Ausbau des Produktportfolios und die Zielorientierte Weiterentwicklung des World Builders zu sichern.

Skills & Technologies:

Screenshots:

Künstliche Intelligenz (KI) wird im Raumfahrtbereich zunehmend genutzt, um aus den heterogenen,......

CALLISTO

Beschreibung:

Künstliche Intelligenz (KI) wird im Raumfahrtbereich zunehmend genutzt, um aus den heterogenen, georeferenzierten Daten von Satelliten und weiteren Quellen wertsteigernde Erdbeobachtungsprodukte zu generieren. Im CALLISTO‑Projekt werden diese Daten mithilfe von High‑Performance‑Computing für skalierbare Analysen kombiniert mit GEO‑Positionierung, UAV‑Beobachtungen, Web‑ und Social‑Media‑Inhalten sowie On‑Site‑Sensoren. KI‑Methoden, die auch an der Edge ausgeführt werden, extrahieren semantisches Wissen (Konzepte, Änderungen, Aktivitäten, 3‑D‑Modelle, Videos) und liefern Analyseergebnisse über nicht‑traditionelle Schnittstellen wie Augmented, Virtual und Mixed Reality an Endnutzer. Auf Anfrage wird eine Data‑Fusion aus den verschiedenen Quellen bereitgestellt, um neue VR/AR‑Anwendungen für Wasserverbände, Journalisten, EU‑Landwirtschaftspolitik und Sicherheitsbehörden zu ermöglichen. Teilaufgaben des Projekts umfassen die Überwachung von Agrarfeldern für EU‑Subventionen, die Messung der Luftqualität in unterschiedlichen Höhen, die Analyse der Wasserqualität von Flüssen und Seen sowie die Erkennung von Änderungen an EU‑Grenzen für die Grenzsicherheit.

Aufgaben:

Wir haben Smartphone-Apps für die Endnutzer entwicklt, die die gesammelten Daten mittels Augmented‑Reality überlagert anzeigen. Dabei habe ich die Softwarearchitektur entworfen, ein benutzerfreundliches Bedienkonzept (UX) umgesetzt und für manche Datensätze die Visualisierung realisiert.

Skills & Technologies:

Videos:

Das Projekt i‑Game wird im Rahmen des Horizon‑Europe‑Programms realisiert. Ziel ist es, eine......

i-Game

Beschreibung:

Das Projekt i‑Game wird im Rahmen des Horizon‑Europe‑Programms realisiert. Ziel ist es, eine offene, benutzerfreundliche Plattform zu schaffen, auf der Entwicklerinnen, Designerinnen, Endnutzern und Fachleute aus Kultur‑ und Kreativsektoren gemeinsam Open‑Source‑Spiele entwickeln können. Der Fokus liegt darauf, Videospiele als kulturelles und wirtschaftliches Phänomen zu nutzen, um Innovationen voranzutreiben und gleichzeitig einen positiven Einfluss auf gesellschaftliche Zusammenhalt, Nachhaltigkeit und Wirtschaftswachstum zu erzielen.

Die Plattform bietet ein Netzwerk, das Experten unterschiedlicher Hintergründe, von Game‑Designern über Entwicklern bis hin zu Nutzern, zusammenbringt. Sie stellt moderne Tools für die Co‑Creation von Spielen für mobile Geräte und Virtual‑Reality‑Umgebungen bereit und fördert die Beteiligung aller Beteiligten. Darüber hinaus wird eine ethische Designkultur etabliert, um verantwortungsbewusstes Gameplay zu gewährleisten. Die Plattform überwacht und bewertet kontinuierlich den Einfluss von Videospielen auf Kultur (z. B. Museen), kreative Industrien und die Mode‑ bzw. Textilbranche und analysiert, wie Online‑Spiele das Wohlbefinden, die Kultur und die Gesellschaft positiv prägen. Durch diese Erkenntnisse können neue Spielegenerationen entwickelt werden, die das individuelle Wohlbefinden verbessern.

Die zugrunde liegende Community‑Orientierung ermöglicht es, aus einem vielfältigen Teilnehmer‑Pool neue Ideen, Kooperationen und Geschäftsmodelle zu generieren, ein besonderer Fokus wird hierbei auf künstliche Intiligenz (KI) gelegt. Neben der Bereitstellung von digitalen Werkzeugen unterstützt die Plattform die Definition, Gestaltung und Umsetzung von Beziehungen, Kooperationen und Spielen. Das Konsortium, bestehend aus Organisationen mit unterschiedlichem Hintergrund und Fachwissen, sorgt für einen interdisziplinären Ansatz, der die komplexen Auswirkungen von Spielen auf Innovation, Nachhaltigkeit, soziale Kohäsion und wirtschaftliches Wachstum umfassend adressiert.

Aufgaben:

Als Entwicklerberater im i‑Game‑Projekt habe ich meine Expertise als Spieleentwickler zusammen mit den Bedürfnissen der Entwickler‑Stakeholdergruppe in die Plattformstrategie eingebracht. Außerdem war ich an der Ausarbeitung von Gesetzes‑ und Regulierungsempfehlungen beteiligt, die sich speziell auf den Einsatz von Künstlicher Intelligenz in der Spieleentwicklung sowie in kreativen Prozessen konzentrieren. In enger Zusammenarbeit mit Juristen habe ich Fragen rund um Urheberrecht, Lizenzierung und ethische Standards aus Entwicklersicht erörtert und die aktuellen technologischen Möglichkeiten dargestellt, sodass im Projekt Vorschläge für die EU‑Kommission zur Gesetzgebung erarbeitet werden konnten. Parallel dazu habe ich KI‑Funktionalitäten in den World Builder integriert, um die Einstiegshürde für die Entwicklung von VR‑Erlebnissen in Museen und anderen kulturellen Einrichtungen zu senken und den Nutzern der Plattform einen leistungsstarken, leicht zugänglichen KI‑gestützten Baukasten bereitzustellen.

Skills & Technologies:

MISTAL (Mitigation of Environmental Impacts on Subclinical and Long‑Term Health Outcomes) ist ein......

ASHVIN

Links:

Beschreibung:

MISTAL (Mitigation of Environmental Impacts on Subclinical and Long‑Term Health Outcomes) ist ein interdisziplinäres Forschungsprojekt, das ein dynamisches, datenschutzfreundliches Health‑Impact‑Assessment‑Toolkit entwickelt, um die Auswirkungen von Umweltfaktoren auf zukünftige Behinderung und Lebensqualität der Bevölkerung vorherzusagen. Durch die Kombination von Umwelt‑, sozioökonomischen, geografischen und klinischen Daten, ergänzt um Lifestyle‑ und individuelle Gesundheitsparameter aus groß angelegten digitalen Bevölkerungsumfragen, nutzt das Toolkit ein Federated‑Learning‑Framework, das eine Integration heterogener Datenquellen ermöglicht, ohne personenbezogene Informationen zentral zu speichern. Die Modelle werden an realen Industrieexpositionen mit Stahlanlagen in Taranto (Süditalien), Rybnik (Polen) und Flandern (Belgien) trainiert und validiert, wobei die Einflüsse von Luftschadstoffen wie Partikeln, Stickstoffoxiden und Schwefeldioxid auf subklinische Gesundheitsparameter systematisch untersucht werden. Das Ergebnis ist ein validiertes, anwenderfreundliches HIA‑Toolkit, das Politikbehörden, Umweltorganisationen, Gesundheitsdienstleister, Versicherungsunternehmen und Patientenorganisationen dabei unterstützt, die langfristigen gesundheitlichen Folgen von Umweltbelastungen frühzeitig zu erkennen und gezielte Interventionsstrategien zu entwickeln, um die globale Krankheitslast zu reduzieren und die Lebensqualität in betroffenen Regionen nachhaltig zu verbessern.

Aufgaben:

Bisher war ich ausschließlich als Berater im MISTAL‑Projekt tätig, da die konkreten Aufgaben noch nicht anstehen. Meine Rolle konzentriert sich auf die Visualisierung der Projektdaten für die Bevölkerung. In diesem Bereich habe ich meine Expertise eingebracht, eng mit den Partnern zusammengearbeitet, um sinnvolle Datenformate zu definieren, und mehrere Vorschläge für ansprechende und verständliche Visualisierungsmöglichkeiten entwickelt, die sowohl die wissenschaftliche Genauigkeit als auch die Zugänglichkeit für Laien gewährleisten.

Skills & Technologies:

MindSpaces - Adaptive und inklusive Räume für die Zukunft

MindSpaces ist ein......

Mindspaces

Beschreibung:

MindSpaces - Adaptive und inklusive Räume für die Zukunft

MindSpaces ist ein interdisziplinäres EU-Projekt, das Künstlern, Technologiefachleute und Architekten zu einer neuen Arbeitsweise verknüpft, um innovative, emotionale und funktionale Raumkonzepte für Städte, Arbeitsplätze und Wohnumgebungen zu entwickeln. Ziel ist es, adaptive “MindSpaces” zu schaffen, die sich in Echtzeit an die emotionalen, ästhetischen und gesellschaftlichen Reaktionen der Nutzerinnen anpassen und dadurch sowohl die Nutzungseffizienz als auch das emotionale Wohlbefinden steigern. Dabei setzen die Projektpartner auf neueste multisensorische Technologien z.B. Wearable-EEG, Herzfrequenzmessung, galvanische Hautreaktion, Umgebungssensorik, sowie Social-Media‑Inputs, um unmittelbare Rückmeldungen aus den VR‑Installationen zu gewinnen und die Kunstwerke in Echtzeit zu modifizieren.

Das Projekt arbeitet mit einem offenen Call-System, um Künstlern aus aller Welt einzubeziehen und residieren zu lassen. In Barcelona arbeitet der Partner‑Cluster mit der Espronceda‑Organisation zusammen, um Künstlern aus der Region L’Hospitalet zu gewinnen und ihre kreativen Ideen in die digitalen Entwürfe einzubringen. Zu den renommierten Partnern gehören digitale Künstler Maurice Benayoun und Refik Anadol sowie Tobias Klein, Jean‑Baptiste Barrière und das Brain Factory/Brain Cloud‑Projektteam, die ihre Expertise in öffentlichen Kunstinstallationen und technologisch fortgeschrittenen Projekten einbringen.

Konzepte und Entwürfe entstehen zunächst als 3‑D‑Modelle, die von Architekten und Künstlern gemeinsam ausgearbeitet werden. Diese Modelle dienen als Grundlage für VR‑Umgebungen, die in Echtzeit auf EEG‑ und physiologische Messdaten der Nutzer reagieren. Durch adaptive Algorithmen werden Designparameter wie Beleuchtung, Akustik und Raumaufteilung dynamisch angepasst, sodass die Räume sofort auf die emotionalen Bedürfnisse der Menschen eingehen. Diese Vorgehensweise ermöglicht die schnelle Validierung von KI‑gestützten Designlösungen in kontrollierten, aber realistischen Szenarien und schafft so eine Brücke zwischen künstlerischer Vision und evidenzbasierter Raumgestaltung.

Aufgaben:

Ich habe die Anwendungen in beiden Use Cases eigenständig entwickelt.

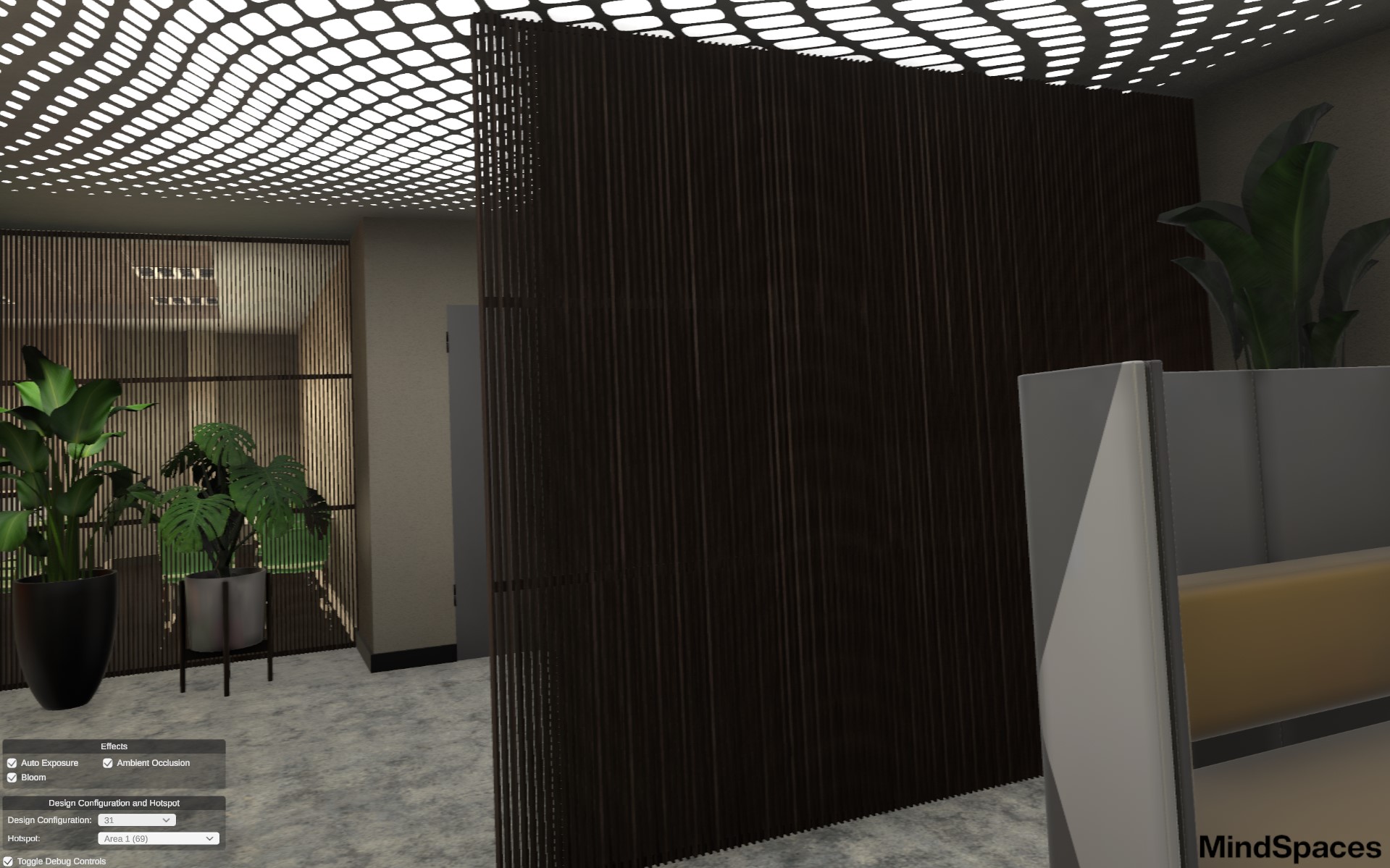

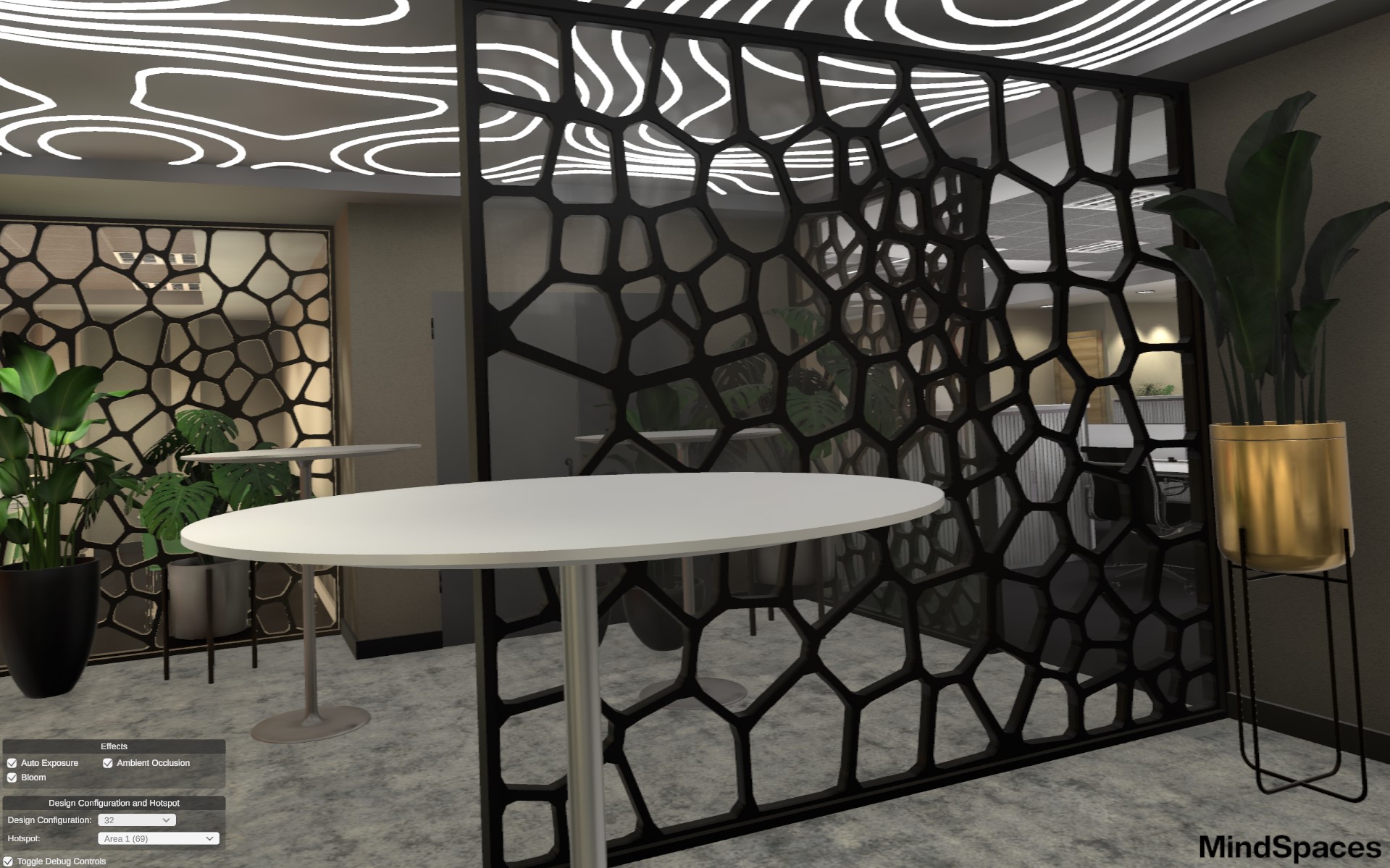

Use Case 1 - Versuchsstudie zu Büro‑Layouts (Workplaces.ai)

Für die experimentelle Untersuchung von Arbeitsräumen habe ich die gesamte Anwendung entwickelt, die es den Teilnehmer ermöglicht, verschiedene Büro‑Layouts zu erkunden, ihr Favorites‑Design auszuwählen und die Räume anhand mehrerer Kriterien (Arbeitszufriedenheit, kognitive Belastung, ästhetischer Eindruck, Effizienz der Arbeitswege) zu bewerten. Während des Tests wurden gleichzeitig medizinische Biomarker (z. B. Herzfrequenz, Hautleitfähigkeit), Bewegungsdaten (z. B. Gehwege und Zeiten) sowie visuelle Messungen (z. B. Fokuspunkte und Objekte im Blickfeld) erfasst. Diese multidimensionalen Datensätze dienen dazu, optimale und möglichst anpassungsfähige Arbeitsumgebungen zu identifizieren, insbesondere die Kürze der Wege, die Übersichtlichkeit des Layouts und der Wohlfühlfaktor. Durch die quantitative Analyse dieser Messwerte lassen sich die besten Raumkonzepte bereits vor dem eigentlichen Umbau präzise bestimmen.

Use Case 2

In Use Case 2 entwickelte ich die interaktiven Visualisierungen für die Innenraum‑ und Campus‑Designs sowie die Multi‑User‑Umgebung auf der fiktiven griechischen Insel, sodass sämtliche Anwendungen funktional, benutzerfreundlich und für die jeweiligen Testgruppen (Senioren, Architekturstudenten) optimiert wurden.

Skills & Technologies:

Screenshots:

Videos:

Das Projekt entwickelte eine mobile App, in der Migranten ihren eigenen Avatar gestalten konnten,......

WELCOME

Beschreibung:

Das Projekt entwickelte eine mobile App, in der Migranten ihren eigenen Avatar gestalten konnten, der anschließend in einer immersiven virtuellen Realität eingesetzt wurde. In dieser VR‑Umgebung standen mehrere Mini‑Spiele zur Verfügung: ein Geographie‑Rätsel, das die neuen Bewohner spielerisch mit den wichtigsten Orten und Regionen des Aufnahmelandes vertraut machte, ein Wort‑Rätsel, das wesentliche Vokabeln und Redewendungen vermittelte, und ein Rollenspiel‑Rätsel zum Thema Bewerbung, in dem die Nutzer praxisnah erfuhren, welche Unterlagen nötig waren und welche Fragen typischerweise von Arbeitgebern gestellt wurden. Durch die Kombination aus personalisiertem Avatar, interaktiver VR und sprachlich‑kulturell angepassten Lerninhalten bot das Projekt einen praxisnahen, motivierenden Ansatz, um Migranten bei der Registrierung, Orientierung, Sprach- und Integrationsförderung sowie der gesellschaftlichen Teilhabe zu unterstützen. Gleichzeitig wurden Entscheidungsträgern in öffentlichen Verwaltungen datenbasierte Analyse‑ und Entscheidungsunterstützungstools bereitgestellt, um die Integration effektiv zu begleiten und zu verbessern.

Aufgaben:

Ich übernahm das Projekt von meinem Vorgänger als Team Lead. In dieser Rolle betreute ich die Entwickler und Artists, überwachte den Fortschritt und intervenierte bei auftretenden Problemen, etwa bei Performance‑Herausforderungen oder UX‑Fragestellungen. Wie in allen Projekten war ich für die finale Qualitätsprüfung verantwortlich und habe die App ausgeliefert.

Skills & Technologies:

Im Rahmen dieses Projekts wurde ein erster simpler Demonstrations-Prototype für eine......

BUNDESWEHR

Beschreibung:

Im Rahmen dieses Projekts wurde ein erster simpler Demonstrations-Prototype für eine VR‑Simulationssystem konzipiert und entwickelt, das zivilen Rettungskräften, Polizeibeamten und militärischen Einheiten die praxisnahe Vorbereitung auf Anschlags- und Notfallszenarien ermöglicht. Die Simulation unterstützt die bewertende Lageeinschätzung, schnelle Triage und das operative Handeln in hochstressigen Situationen, sodass die Einsatzkräfte ihre Entscheidungsfindung und Koordination unter realistischen Bedingungen trainieren können.

Aufgaben:

Im Rahmen dieses Projekts habe ich als einziger Entwickler in Zusammenarbeit mit einem Artist das VR‑Simulationssystem in etwa zwei Tagen in der Unreal Engine umgesetzt. Dabei wurden sämtliche Kernfunktionen – Real‑Time‑Lageeinschätzung, Triage‑Mechanik und die Darstellung dynamischer Notfallszenarien – in kurzer Zeit zum Laufen gebracht und auf die Bedürfnisse von Rettungskräften, Polizei und Militär zugeschnitten.

Skills & Technologies:

Fantasy Fitness Fights VR ist ein virtuelles Rogue‑Lite‑Exergame, das Spieler in eine......

FANTASY FITNESS FIGHTS

Links:

Beschreibung:

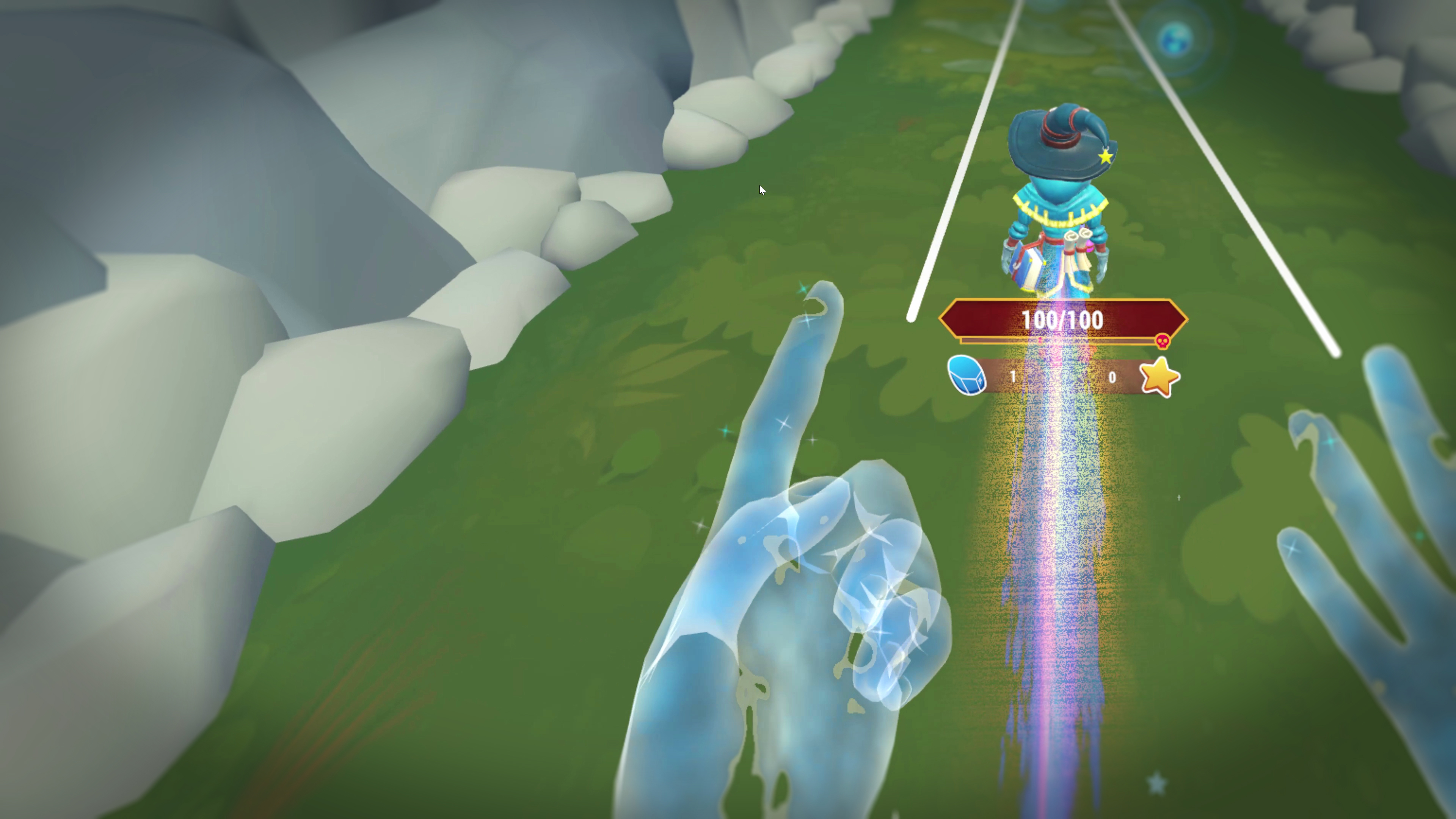

Fantasy Fitness Fights VR ist ein virtuelles Rogue‑Lite‑Exergame, das Spieler in eine fantastische Welt mit Magie und Abenteuern entführt, in der sie durch dynamische Hand‑ und Körperbewegungen Gegner bekämpfen. Die vollständig gestenbasierte Steuerung ermöglicht es, sich zu verteidigen, Waffen einzusetzen und Zauber zu wirken – jedes Treffer- oder Verteidigungsmanöver erfordert eine körperliche Bewegung, die gleichzeitig Fitness‑ und Koordinationsfähigkeit fördert. Ziel des Spiels ist es, Bewegungsmangel aktiv vorzubeugen und Gamer aller Erfahrungsstufen – von Gelegenheits‑Gamer bis zu Hardcore‑Spielern – zu motivieren, sich fit und gesund zu halten, indem sie spielerisch anspruchsvolle körperliche Herausforderungen meistern. Durch ein actiongeladenes Gameplay, vielfältige Gegner und ein progressives Belohnungssystem verbindet „Fantasy Fitness Fights VR“ Spaß, Abenteuer und körperliche Aktivität in einer einzigartigen VR‑Erfahrung.

Aufgaben:

Ich war maßgeblich am Prototyping des Projekts beteiligt, wobei der Schwerpunkt auf der Bewegungs‑Erkennung lag. In den ersten Entwicklungsphasen haben wir verschiedene Ansätze evaluiert: neben klassischen Beschleunigungsmuster‑Erkennungen (feature‑basierte Klassifikatoren auf Basis von Gyroskop‑ und Accelerometer‑Daten) haben wir auch moderne Machine‑Learning‑Methoden eingesetzt – von einfachen Entscheidungsbäumen bis hin zu tiefen neuronalen Netzen, die auf Zeitreihendaten trainiert wurden.

Skills & Technologies:

Screenshots:

Videos:

DIVAN Kids ist eine innovative, webbasierte App, die Kindern im Alter von 7 - 12 Jahren mit......

DIVAN KIDS

Links:

Beschreibung:

DIVAN Kids ist eine innovative, webbasierte App, die Kindern im Alter von 7 - 12 Jahren mit Angststörungen evidenzbasierte Therapie‑ und Psychoedukations‑Inhalte bietet, die durch Gamification motivierend verpackt sind. Parallel zur App stellt ein Eltern‑/Therapeuten‑Portal ein transparentes Monitoring bereit. Der gesamte Entwicklungsprozess folgt einem nutzer‑zentrierten, iterativen Ansatz und wird von einer Bundes‑Förderung über drei Jahre getragen.

Aufgaben:

In der Anfangsphase des DIVAN Kids-Projekts arbeitete ich beratend im Team an der strategischen Ausrichtung der Technologie‑ und Hardware‑Architektur. abei lag mein Fokus insbesondere auf der Wahl des geeigneten Einsatzmediums also VR, mobile App, Desktop‑App oder Web‑Plattform und darauf, welche Variante die bestmögliche Nutzererfahrung für die Zielgruppe von Kindern, Eltern und Psychotherapeuten bieten würde. Zusätzlich beriet ich das Projekt bei der technischen Verknüpfung des Eltern‑/Therapeuten‑Portals mit der eigentlichen Gaming‑Anwendung, sodass Datenflüsse und Interaktionen nahtlos funktionieren und gleichzeitig den Datenschutzanforderungen entsprechen.

In den frühen Phasen habe ich mitgewirkt, ein Einsatzkonzept für Ärzte und Patienten zu entwickeln. Dabei erarbeitete ich Szenarien, wie die App in ambulanten Therapiesitzungen eingebunden und im Alltag der Kinder genutzt werden kann, um die Wirksamkeit und Akzeptanz zu fördern.

Hier entwickelte ich Szenarien, wie die App in ambulanten Therapie‑Sitzungen eingebunden und im Alltag von Kindern genutzt werden kann, um die Wirksamkeit und Akzeptanz zu erhöhen. Auch in der Ideenfindung für spielerische Elemente – von Mini‑Spielen über narrative Storylines bis hin zu Belohnungssystemen – konnte ich kreative Vorschläge einbringen, die später die Basis für die Gamification‑Bausteine bildeten.

Nach der Entscheidung, die Anwendung als Web‑App umzusetzen, zog ich mich aus dem Projekt zurück, um anderen Teammitgliedern die Möglichkeit zu geben, die nächsten Entwicklungs‑ und Implementierungsphasen voranzutreiben.

Skills & Technologies:

Das Projekt COMPASS zielt darauf ab, die Navigation in der minimalinvasiven Chirurgie durch ein......

COMPASS

Beschreibung:

Das Projekt COMPASS zielt darauf ab, die Navigation in der minimalinvasiven Chirurgie durch ein intelligentes Assistenzsystem grundlegend zu verbessern. Aufgrund des eingeschränkten Sichtfelds bei endoskopischen Eingriffen stoßen Chirurginnen und Chirurgen oft an technische und kognitive Grenzen. Mithilfe von 3D-Endoskopie und Stereobildverarbeitung wird eine dynamische, patientenspezifische anatomische Landkarte erstellt. Diese wird in einer Virtual-Reality-Umgebung dargestellt und ermöglicht eine immersive, intuitive Orientierung innerhalb des Körpers. Die Karte zeigt in Echtzeit relevante anatomische Strukturen, Richtungsinformationen und Hinweise zu den nächsten OP-Schritten, die sich fortlaufend an die aktuelle Position und Bewegung des Endoskops anpassen. Die VR-gestützte Darstellung unterstützt das räumliche Verständnis und erleichtert die Navigation in schwer einsehbaren Regionen. Durch die Kombination aus intelligenter Visualisierung und interaktiver Führung wird die operative Präzision erhöht und die Belastung für das chirurgische Team reduziert. Ziel ist es, durch die Integration solcher Assistenzsysteme die Sicherheit, Effizienz und Akzeptanz minimalinvasiver Eingriffe nachhaltig zu steigern.

Aufgaben:

Drei Monate vor Abschluss des COMPASS-Projekts habe ich die technische Leitung übernommen und den Entwicklungsprozess in der finalen Phase verantwortet. In enger Zusammenarbeit mit dem zuständigen Entwickler habe ich die Arbeiten strategisch koordiniert und gezielt auf die Fertigstellung des Systems ausgerichtet. Mein Schwerpunkt lag auf der technischen Beratung bei der Implementierung sowie der systematischen Fehlersuche und -behebung. Durch die Analyse bestehender Probleme und die Entwicklung praxisnaher Lösungen konnten wir zentrale Funktionen stabilisieren und die Integration der Komponenten erfolgreich abschließen.

Skills & Technologies:

SMART‑EAT verbindet Public‑Health‑Forschung, VR/AR‑Softwareentwicklung, Gamification und......

SMART EAT

Links:

Beschreibung:

SMART‑EAT verbindet Public‑Health‑Forschung, VR/AR‑Softwareentwicklung, Gamification und Sozialpsychologie, um Schülern interaktive Lernwelten zu bieten, die ernährungswissenschaftliche Inhalte mit modernen Technologien verknüpfen. In einer VR‑Brille betreten die Jugendlichen einen virtuellen Supermarkt, treffen Entscheidungen über Produkte, Verpackungen und gesellschaftliche Einflüsse und erhalten anschließend personalisiertes, gesünderes und nachhaltigeres Feedback (Nutri‑Score, ökologische Siegel).

Aufgaben:

Das Projekt befindet sich aktuell in der Pre‑Production‑Phase. In dieser Phase liegt mein Fokus auf der Requirements‑Analyse, der Szenarioentwicklung und der Ausarbeitung der Softwarearchitektur. Durch die enge Zusammenarbeit mit den Fachexperten aus Public Health, VR/AR‑Engineering, Gamification und Sozialpsychologie stelle ich sicher, dass die funktionalen und nicht‑funktionalen Anforderungen klar definiert, die Lern‑ und Entscheidungsszenarien nachvollziehbar modelliert und die technische Grundlage für die spätere Implementierung stabil gestaltet werden.

Skills & Technologies:

DigiEat entwickelt verhaltenstherapeutisch fundierte VR‑Szenarien, die soziale Esssituationen......

DIGI EAT

Beschreibung:

DigiEat entwickelt verhaltenstherapeutisch fundierte VR‑Szenarien, die soziale Esssituationen realistisch simulieren und durch gezielte Geruchsreize (Olfaktorik) die Immersion verstärken. Das System synchronisiert die VR‑Erfahrungen mit Duftexpositionsgeräten und ermöglicht so personalisierte, scent‑basierte Therapiemodule. Dadurch können Patienten neben der ambulanten Therapie auch zu Hause intensive, akute sowie Erhaltungsübungen durchführen – Wartezeiten werden verkürzt und der langfristige Therapieerfolg verbessert. Die Kombination aus VR‑Simulationen und Dufttechnologie schließt die bislang bestehende Lücke zwischen konventioneller Verhaltenstherapie und digitaler Unterstützung.

Aufgaben:

Mein Team sollte die Entwicklung der VR-Anwendung übernehmen. Es wurden Vorarbeiten und Anpassungen an unserem breits in ReliVR entwickelten System unternommen. Die Ausarbeitung und Design der Szenarien hat bis jetzt noch nicht stattgefunden.

Skills & Technologies:

REEVALUATE ist ein Horizon‑Europe-Projekt, das eine ganzheitliche Lösung für die Verwaltung der......

REEVALUATE

Beschreibung:

REEVALUATE ist ein Horizon‑Europe-Projekt, das eine ganzheitliche Lösung für die Verwaltung der Digitalisierung von Kulturgut (CH) entwickelt. Ziel ist es, die Zusammenarbeit zu fördern, die kreative Wiederverwertung zu stärken und eine demokratische sowie inklusive Priorisierung und Kontextualisierung zu ermöglichen. Nach einer ersten Analyse der bestehenden Schwachstellen und Chancen in der CH‑Digitalisierung wird ein modularer Rahmenwerk erstellt, das sämtliche Phasen des Lebenszyklus eines digitalisierten Artefakts abdeckt – von der Priorisierung über die Kontextualisierung, die sichere Speicherung, die Zusammenarbeit bis hin zur Wiederverwendung. Dieses Rahmenwerk wird durch eine Reihe technologischer Enabler unterstützt, deren freie Versionen von der Kooperationsgemeinschaft für die Integration in die European Cultural Heritage and Creative Economy (ECCCH) bereitgestellt werden. Im Zentrum steht die Beteiligung aller Stakeholder, die über die Enabler ihre Sichtweisen zu den Artefakten äußern und diese effektiv wiederverwenden können. Künstliche Intelligenz wird im gesamten Prozess eingesetzt: Sie unterstützt die manuelle Kontextualisierung, verbessert die Priorisierung durch öffentliche Sensortechnologien, visualisiert Ideen für kreative Wiederverwendungen, schlägt Kollaborationen und Einsatzszenarien vor und prüft die Kontextualität der wiederverwendeten Objekte. Das Rahmenwerk berücksichtigt zudem die sichere Speicherung der digitalen Artefakte und gestaltet die Rechte an geistigem Eigentum durch Tokenisierung der CH‑Objekte sowie die Einführung von Smart Contracts für die Wiederverwendung. Ergänzend bietet es eine standardisierte semantische Darstellung der Metadaten an, um die Zugänglichkeit, Entdeckbarkeit und die automatisierte Erkennung von Missbrauch digitalisierter CH‑Objekte zu verbessern. Die einzelnen Enabler von REEVALUATE können je nach Bedarf von Kulturgut‑Institutionen einzeln oder als Ganzes eingesetzt werden. Insgesamt liefert das Projekt dem europäischen CH‑Sektor ein Werkzeugset, das die effektive Verwaltung digitalisierter Sammlungen ermöglicht, den Prozess für die Gesellschaft öffnet und die Schaffung gesellschaftlichen Mehrwertes durch kreative Wiederverwendung von Kulturgut fördert.

Aufgaben:

Ich war in der Planungsphase des REEVALUATE‑Projekts in einer kurzen, beratenden Funktion aktiv. Dabei habe ich das Projekt mit meiner Erfahrung im Bereich Gamification unterstützt und Ideen für Minigames zu Demonstrationszwecken ausgearbeitet, die die Interaktion mit digitalisierten Kulturgütern unterhaltend und reizvoll fördert.

Skills & Technologies:

COOLCUT

Das Projekt „COOLCUT“ ist ein dreijähriges Vorhaben, das sich dem Ziel verschrieben hat, ein......

COOLCUT

Beschreibung:

Das Projekt „COOLCUT“ ist ein dreijähriges Vorhaben, das sich dem Ziel verschrieben hat, ein hochpräzises, minimalinvasives Lasersystem für die Entfernung von Knochen‑Tumoren im Kiefer- und Gesichtsschädelbereich zu entwickeln. Die Operation wird dabei in Echtzeit von laser‑spektroskopischer Tumordetektion begleitet und von einem robotergestützten Navigationssystem unterstützt.

Zu den Hauptpartnern zählen das Fraunhofer‑Institut für Lasertechnologie ILT, die Abteilung für Mund‑Kiefer‑Gesichtschirurgie am RWTH‑Aachen‑Universitätsklinikum und EdgeWave GmbH. Nuromedia GmbH trägt die Verantwortung für die AI‑gestützte medizinische Bildverarbeitung und die operationelle Planung. Darüber hinaus entwickelt Nuromedia ein virtual‑reality‑basiertes Navigations‑ und Steuerungssystem, das die chirurgische Präzision erhöht, sowie eine KI‑unterstützte Adaptation der robotergestützten Assistenz, die die Laser‑Schneidparameter in Echtzeit anpasst.

Das Ergebnis soll ein vollständig integriertes System sein, das die Strukturbeschädigung minimiert, die Therapiezeit verkürzt und die Erfolgsquote bei der Behandlung von Kaumaxillärtumoren nachhaltig verbessert.

Aufgaben:

Ich war nur kurz zu Beginn des Projektes in der Umsetzungskonzeption beteiligt. Hierbei lag mein Fokus auf dem Design des Navigationssystems.

Skills & Technologies:

Portals United ist eine umfassende Online‑Plattform für Entwickler, die sich mit dem......

Portals United

Links:

Beschreibung:

Portals United ist eine umfassende Online‑Plattform für Entwickler, die sich mit dem World‑Builder‑ und Portal‑Hopper‑Ökosystem beschäftigen. Die Webseite bietet ein interaktives Forum, in dem Programmierer Fragen stellen, Code‑Snippets teilen und gemeinsam an Projekten arbeiten können. Ergänzt wird das Forum durch ausführliche Dokumentation und Schritt‑für‑Schritt‑Tutorials, die die Nutzung des World Builders, der Portal Hoppers und der angrenzenden VR‑Technologien (wie VRWeb) transparent machen. Zusätzlich wurden die wichtigsten Teile von VRWeb erläutert und die VRML‑Protocol‑Definition veröffentlicht, sodass Entwickler klare Vorgaben für die Kommunikation zwischen virtuellen Welten und ihrer Infrastruktur erhalten. Portals United fungiert somit als zentrale Wissens‑ und Kollaborations‑Nexus für die VR‑Community.

Aufgaben:

Ich habe die komplette Webseite von Grund auf aufgebaut, die Struktur des Entwickler‑Forums sowie die Seiten für Dokumentation und Tutorials des World Builders und Portal Hopper konzipiert und umgesetzt. Gemeinsam mit meinem Team haben wir die Inhalte eingepflegt, die VRWeb‑Module dokumentiert und die VRML‑Protocol‑Definition veröffentlicht. Im Forum haben wir aktiv Fragen beantwortet, Support geleistet und den Austausch zwischen Entwicklern gefördert.

Skills & Technologies:

VRWeb befindet sich aktuell im Konzeptionierungsstadium und baut auf einer Vielzahl von......

VRWeb

Links:

Beschreibung:

VRWeb befindet sich aktuell im Konzeptionierungsstadium und baut auf einer Vielzahl von Forschungs‑ und Förderprojekten auf. Ziel ist die Schaffung eines verteilten Metaverses, das Entertainment, Bildung und Healthcare auf einer einzigen, demokratisch gestalteten Plattform vereint – kein einzelner Akteur besitzt das System. Durch die Einbindung des neuen Web‑Paradigmas (Web 3.0) entsteht ein datenschutzorientierter Rahmen, in dem Inhalte zentral verteilt, Altersfreigaben dynamisch verwaltet und ein transparentes Bezahlsystem betrieben werden.

Eine zentrale Idee des Projekts ist die Nutzung von VR und AR, um Inhalte, die bislang ausschließlich im 2‑D‑Raum auf Bildschirmen präsentiert werden, in einen echten 3‑D‑Umgebung zu überführen. Dadurch entsteht ein immersiver Mehrwert, der die Aufmerksamkeit der Nutzer stärker auf 3‑D‑Inhalte lenkt und neue Lern‑, Unterhaltungs‑ und Therapie‑Erlebnisse ermöglicht. Diese Technologie soll als Kernkomponente im Distributed Metaverse verankert werden, um nahtlose Übergänge zwischen klassischen 2‑D‑Displays und immersiven 3‑D‑Räumen zu realisieren.

Aufgaben:

Ich habe maßgeblich an der Ausarbeitung des VRWeb‑Konzepts mitgewirkt, von der Ideenfindung bis zur Definition von VR/AR‑, Datenschutz‑ und Bezahlsystemen. Dabei habe ich eng mit den Forschungs‑ und Förderpartnern zusammengearbeitet, um die Vision eines demokratischen, 3‑D‑zentrierten Metaverses in die konkrete Projektplanung zu überführen.

Skills & Technologies:

VRML ist ein XML‑basiertes Dateiformat, das angibt, wie ein Ort in einer VR‑Umgebung angezeigt......

VRML

Links:

Beschreibung:

VRML ist ein XML‑basiertes Dateiformat, das angibt, wie ein Ort in einer VR‑Umgebung angezeigt werden soll. Unterstützende Software, insbesondere der HOPPER‑Protokoll‑Handler, liest die Datei, lädt die darin referenzierten Inhalte und stellt die beschriebene Erfahrung bereit.

Die ursprüngliche Version 1.0 konnte nicht universell und plattformunabhängig eingesetzt werden, weil sie zu sehr von bestehenden Softwaresystemen abhing. Version 2.0 wurde als offenes, erweiterbares Standardprotokoll entwickelt, um diese Schwächen zu beheben und die Erkenntnisse der letzten Jahre zu integrieren.

VRML v2.0 liefert ein strukturiertes, rechtssicheres und erweiterbares Format, das die Darstellung von VR‑Inhalten zuverlässig steuert.

Eine Streaming‑Variante des Formats ist derzeit in Arbeit, um eine kontinuierliche, datenstrombasierte Darstellung von VR‑Inhalten zu ermöglichen.

Aufgaben:

Gemeinsam mit einem Kollegen habe ich den VRML‑Standard entworfen, verfeinert und bis zur Einsatzreife gebracht. Wir haben die Spezifikation erarbeitet, Implementierungsrichtlinien definiert und die Kompatibilität mit bestehenden HOPPER‑Implementierungen getestet, sodass das Format nun zuverlässig in produktiven VR‑Anwendungen eingesetzt werden kann.

Skills & Technologies:

Für die Westnetz haben wir mehrere Trainings-/Schulungsanwendung entwickelt. Eine......

WESTNETZ

Beschreibung:

Für die Westnetz haben wir mehrere Trainings-/Schulungsanwendung entwickelt. Eine Kriesenfallsimulation im Umspannwerk und eine Einführungslerneinheit für neu digitale Ortsnetzstationen. Die erste Anwendung hat den Fokus auf Abläufe und Kommunikation während die zweite Anwendung den Fokus auf die neue Technik setzte.

Die Projekte werden in diesem Artikel durch einen weiteren Projektpartner (Universität Wuppertal) vorgestellt, siehe unten die Bilder.

Aufgaben:

Die Code-Architektur wurde von mir erarbeitet. Außerdem wurden die meisten System von mir entwickelt. Hervorzuheben sind hier ein Dialogsystem für Telefon- und NPC-Gespräche, Bewertungssysteme für die Handlungen des Users und eine komplette Strom- und Datensimulation einer digitalen Ortsnetzstation.

Skills & Technologies:

Screenshots:

KlimaDigits wurde für die EnergieArgentur.NRW auf Basis der Unreal-Engine für die Pico G2......

KLIMA DIGITS

Beschreibung:

KlimaDigits wurde für die EnergieArgentur.NRW auf Basis der Unreal-Engine für die Pico G2 entwickelt. Zielgruppe sind Schulklassen der Stuffen 7-10 in NRW. Thema dieser Edutainment-Anwendung ist die Energiewende und die Digitalisierung des Stromnetzes. Neben der Anwendung, wurde ein Aufgabenheft entwickelt, welches die Schüler in 2er-Teams zusammen mit einer VR-Brille erarbeiten sollen. Dabei können die Aufgaben nur gemeinsam gelöst werden. Einer der Schüler bekommt Informationen in VR und muss diese dem Partner mitteillen, damit er die Aufgabe lösen kann. In der Mitte der Anwendung tauschen die Schüler ihre "Plätze" und der Andere wird zum VR-User, während der Andere mit dem Aufgabenheft arbeiten muss.

Aufgaben:

Bei diesem Projekt oblag mir der Einbau von 2 Kapiteln und die Unterstützung der Mitarbeiter bei der Implementierung der anderen Kapiteln. Hierbei habe ich sie bei der Fehlersuche als auch im Bereich der Software-Architektur beraten.

Skills & Technologies:

Screenshots:

Für das Bundesministerium für Ernährung und Landwirtschaft (BMEL) haben wir eine......

Grüne Woche

Beschreibung:

Für das Bundesministerium für Ernährung und Landwirtschaft (BMEL) haben wir eine VR-Messe-Showcase (Oculus Rift S) entwickelt. Neben dem eindeutigen Zweck als Messe-Unterhaltung sollten hierbei den Verbrauchern den Unterschied zwischen offiziellen und gefälschten Lebensmittelsiegeln vermittelt werden. Mein Anteil waren vorallen Dingen die Integration des Ablaufes und der Interaktionen mit der Welt. Das Projekt war für Roomscale-VR mit realen Objekten im Trackingbereich ausgelegt. Virtuelle Objekte mussten dabei in einen physischen Einkaufwagen gelegt werden.

Skills & Technologies:

Screenshots:

Für eine landesweite Roadshows habe ich bei senselab.io eine VR-Anwendung (Oculus Go) entwickelt.......

AXA CyberSecurity

Beschreibung:

Für eine landesweite Roadshows habe ich bei senselab.io eine VR-Anwendung (Oculus Go) entwickelt. Ziel war es innerhalb kürzester Zeit eine humorvolle und unterhaltsame Einführung in das Thema IT-Sicherheit und die dazugehörigen Produke der AXA zu liefern. Neben meiner Tätikgeit als Projekt-Lead war ich massgeblich für die Inzenierung und die Animationen verantwortlich. Dies habe ich mittels Timelines und Keyframe-Animationen in Unity umgesetzt.

Skills & Technologies:

Screenshots:

Im Rahmen der BAUMA haben wir für die Messe München eine Multi-User-VR-Experience (HTC Vive Pro +......

BAUMA

Links:

Beschreibung:

Im Rahmen der BAUMA haben wir für die Messe München eine Multi-User-VR-Experience (HTC Vive Pro + Wireless) entwickelt. Ziel war es dem Publikum die Möglichkeiten von VR nahe zu bringen und die Produkte der Sponsoren vorzustellen. Die Bauma-VR-Experience war eine Roomscale VR-Anwendung, bei der sich 4 User (ein Guide und 3 Besucher) eine virtuelle Baustelle besuchen. Die User konnten via Handtracking (Leapmotion) mit der Welt interagieren. Außerdem wurde die Imersion durch eine Rüttelplatte und mehrere Windmaschinen verstärkt. Neben den eigentlichen VR-Modes für Guide und USer wurden auch ein Operator-Mode und ein Zuschauer-Mode entwickelt. Beide Modi wurden ebenfalls erfogreich auf der Messe eingesetzt.

Aufgaben:

Zu meinen Hauptätigkeiten an diesem Projekt gehörte der Netzwerk-Stack, die Entwicklung des Modi-Systems, die DOKA-Aufbauanimation (via Keyframes in Unity), der Einbau von Werbevideos für UVEX und den Zuschauermodus der als eine Fernsehübertragung mit verschiedenen Kameraeinstellung und -fahrten mittels Cinemachine implementiert wurde.

Skills & Technologies:

Screenshots:

„Schaltbefähigung“ ist eine mit dem Immersive Learning Award 2018 ausgezeichnete......

TÜV Süd - Schaltbefähigung

Links:

Beschreibung:

„Schaltbefähigung“ ist eine mit dem Immersive Learning Award 2018 ausgezeichnete Trainings-Applikation, die in Zusammenarbeit mit der TÜV SÜD Akademie entwickelt wurde. Sie wird sehr erfolgreich im Rahmen von Präsenztrainings zur Durchführung virtueller Prüfungsaufgaben wie etwa beim Betreiben elektrischer Anlagen oder dem Spannungsfreischalten eingesetzt.

Im Rahmen des Trainings können auch sehr gefährliche Situationen vollkommen risikolos durchgespielt werden, was der Anwendung neben ihrer Effizienz und Zeitersparnis noch mal einen signifikanten Mehrwert verleiht.

Skills & Technologies:

Screenshots:

Mit Hilfe der VR-Anwendung “HV-Freischalten von Elektromobilen” werden wichtige Arbeitsschritte......

TÜV Süd - HV-Freischalten

Beschreibung:

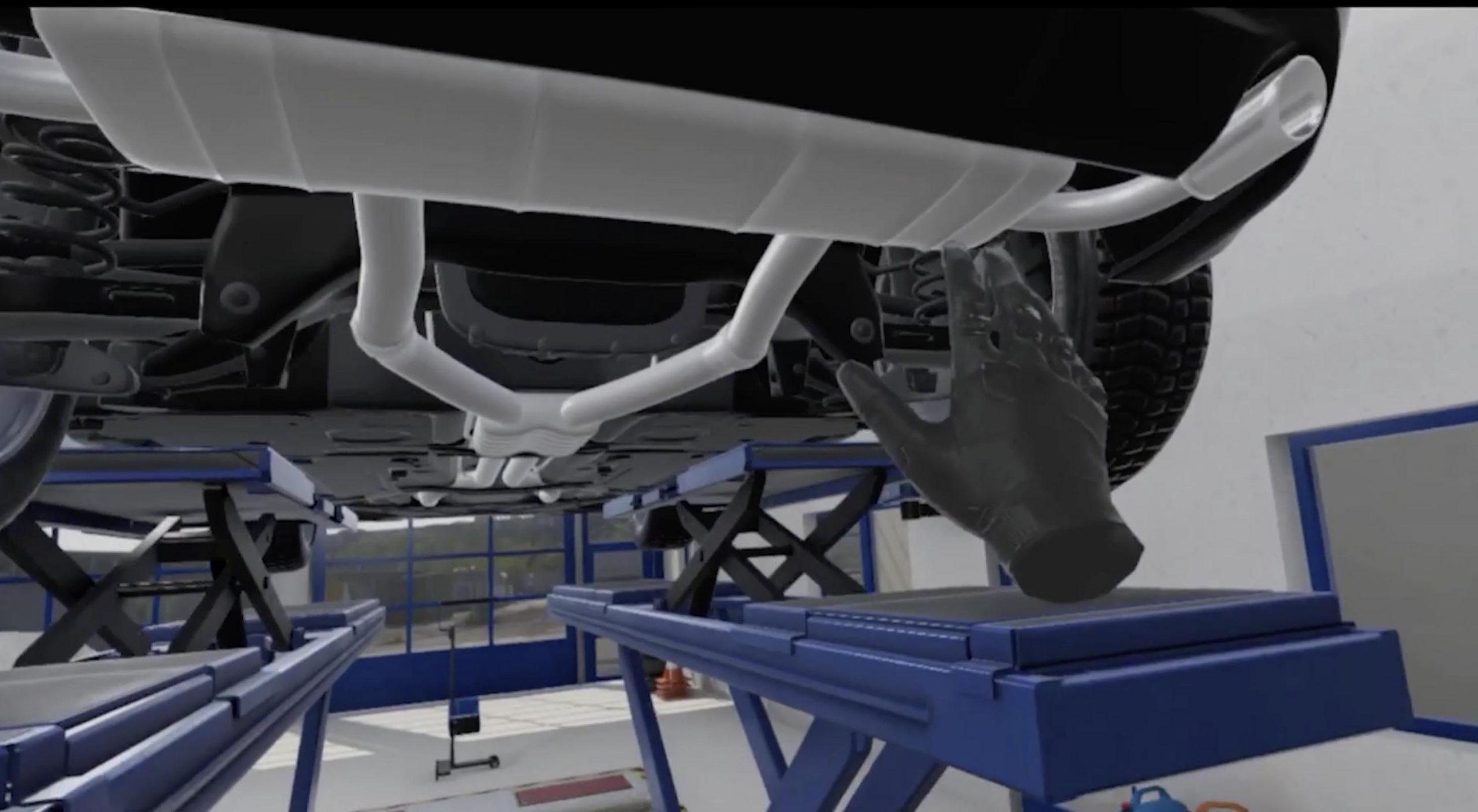

Mit Hilfe der VR-Anwendung “HV-Freischalten von Elektromobilen” werden wichtige Arbeitsschritte für die gefahrlose Wartung von Elektrofahrzeugen trainiert. Kfz-Werkstätten in ganz Deutschland können ihre Angestellten so schnell und günstig für die Reparatur von E-Autos trainieren.

Die realitätsnahe Darstellung eines weit verbreiteten Hybrid-Fahrzeugs ermöglicht ein praxisnahes Training ohne die Gefahren, die von einem echten Hochspannungssystem ausgehen. Die Auswahl der E-Autos wird stetig erweitert, da die Arbeitsschritte je nach Fahrzeug unterschiedlich sind.

Skills & Technologies:

Screenshots:

Valnir Rok ist ein Online-Sandbox-Survival-Rollenspiel, das von der nordischen Mythologie......

Valnir Rok

Beschreibung:

Valnir Rok ist ein Online-Sandbox-Survival-Rollenspiel, das von der nordischen Mythologie inspiriert wurde. Die Spieler wachen auf der Insel Valnir auf und müssen alles tun, um in einem Land voller wilder Tiere, mythischer Kreaturen und brutalen Menschen zu überleben.

Aufgaben:

Zu meinen ersten Aufgaben bei Encurio gehörte es ein komplett neues Kampfsystem zu entwickeln. Die Entwicklung des Kampfsystems machte es zwingend erforderlich einen neuen Netzwerklayer für dieses System zu pogramieren, da der alte schon mit dem bestehenden langsamen Gameplay völlig überfordert war. Aufgrund des Zeitmangels (4 Wochen) wurden nur kritische Informationen auf den neuen Layer übertragen (Movement und Kampf). Der Milestone für Battle for Valhalla (ein Battle Royale Spiel auf der Basis des besteheneden MMORPG Valnir Rok) wurde erreicht, dennoch hat der Publisher das Projekt beendet, da er von der Wirtschaftlichkeit eines Battle Royale Spiels nicht mehr überzeugt war (es lag ausdrücklich nicht an unserer geleisteten Arbeit, mit der sie sehr zufrieden waren). Das neu entwickelte Kampfsystem wurde daher in den darauffolgenden 5 Wochen in Valnir Rok integriert. Darüber hinaus wurden von uns zahlreiche Bugs behoben und die Performance des Spiels massiv verbessert (insbesondere durch einen neuen World Streamer mit einem neuen Grass System und durch ein Mesh-Combine-System).

Skills & Technologies:

Screenshots:

Faith & Honour: Barbarossa ist ein historisch authentisches Abenteuer-RPG, das während der......

Faith + Honor: Barbarossa

Links:

Beschreibung:

Faith & Honour: Barbarossa ist ein historisch authentisches Abenteuer-RPG, das während der Kreuzzüge Friedrichs I. Barbarossa spielt.

Aufgaben:

Nach dem Update für Valnir Rok begann ich mit der Konzeption und Entwicklung für ein neues Spiel, für das wir gerade durch die Film und Medienstiftung NRW Fördergelder zugesichert bekommen hatten. Faith + Honor: Barbarossa ist ein historisches Action-Adventure-RPG mit rundenbasierten taktischem Kampf. Der Spieler begleitet den Hauptcharakter durch ein Abenteuer zur Zeit von Barbarossa und reist durch die Welt des Hochmittelalters den Kreuzfahrern hinterher ins heilige Land. Ziel des Projektes ist es die Rollenspielelemente und den taktischen Kampf so einsteigerfreundlich wie nur möglich zu gestallten und eine Spielzeit von etwa 12-20 Stunden zu erreichen. Neben der Entwicklung und Ausarbeitung von Gameplay-Konzepten oblag mir die Aufgabe der technischen Konzeptentwicklung, sowie der Evaluierung von Engines und Tools.

Skills & Technologies:

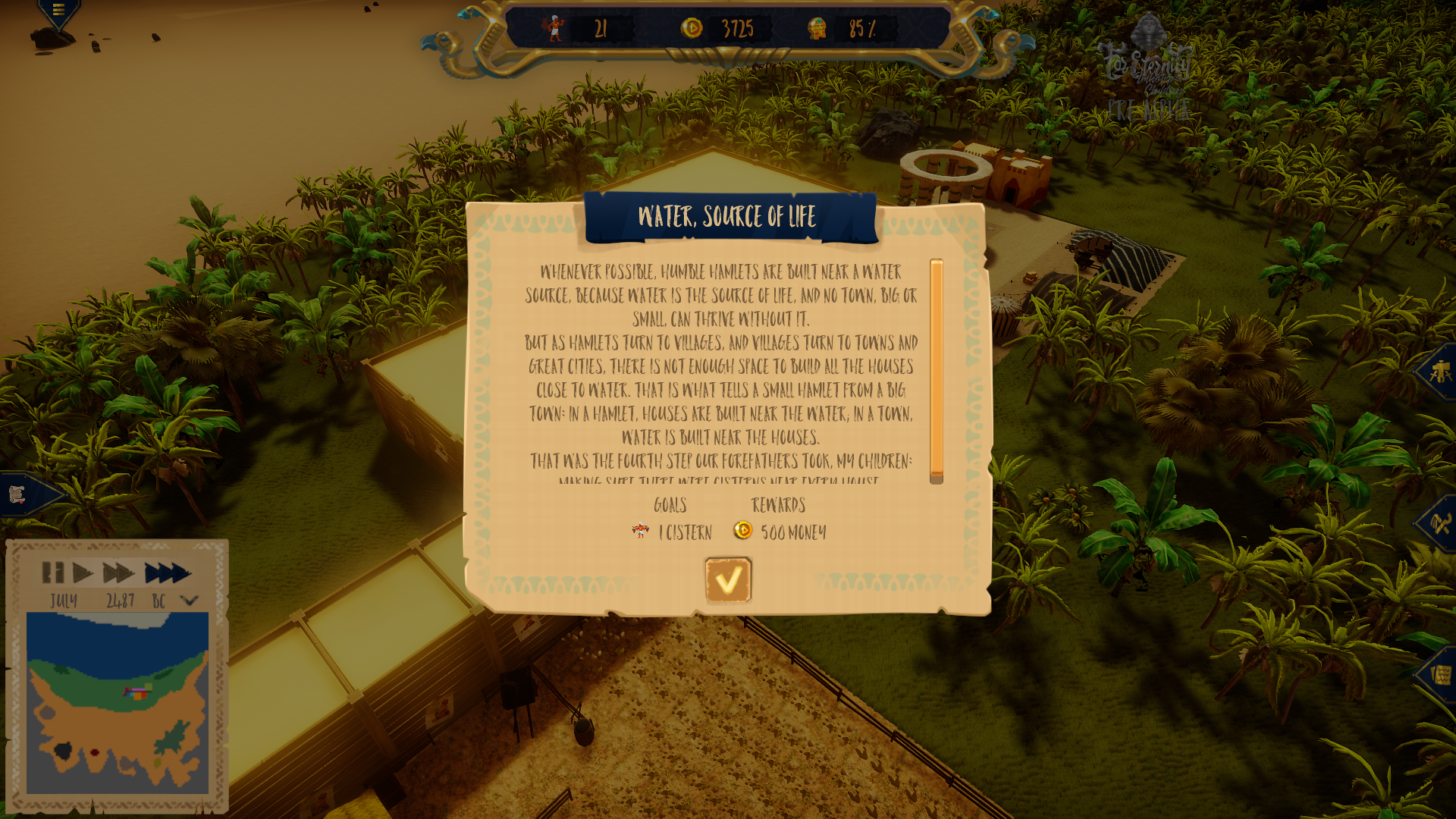

"For Eternity - Imhotep's Children" ist ein eigenes Projekt. Es ist eine Städtebausimmulation......

For Eternity - Imhotep's Children

Beschreibung:

"For Eternity - Imhotep's Children" ist ein eigenes Projekt. Es ist eine Städtebausimmulation angesiedelt im antiken Ägypten zur Hochzeit des Pyramiedenbaus.

Aufgaben:

Dieses Spiel habe ich komplett aleine entwickelt.

Dies ist eine Liste mit den Hauptsystemen, die für das Spiel geplant sind:

- Einstellungs-System (implementiert)

- Lokalisierungs-System (implementiert)

- Audio-System (implementiert)

- Eingabesystem (implementiert)

- Kamera-Steuerungs-System (implementiert)

- Welt- bzw. Kartensystem (implementiert)

- Bausystem incl. Gebäude-Steuerungs-System (implementiert)

- Transportsystem (implementiert)

- Handelssystem mit Angebot und Nachfrage (implementiert)

- Bevölkerungs-System incl. NPC-AI-Steuerungs-System (implementiert)

- Statistiksystem (implementiert)

- Questsystem (implementiert)

- Eventsystem für Gameplay-Ereignisse

- Speicher- und Ladesystem

Im Zusammenhang mit diesem Spiel habe ich die Geschichte, Quest und Events entwickelt und zusammen mit einem Autor geschrieben. Zusätzlich habe ich die Erstellung von Assets durch Freelancern gemanaged z.B. Musik, Voice-Over, UI-Elementen und mehr. Diese gefertigten Assets wurden dann von mir in das Unity-Projekt eingepflegt und mit den von mir programmierten Systemen verbunden. Kein anderer, außer mir, hat innerhalb von Unity an dem Projekt gearbeitet.

Skills & Technologies:

Screenshots: